인사이트

31 July 2025

운영비 절감에 필수적인 LLMOps란 무엇인가?

LLMOps 뜻부터 VESSL AI의 이용 사례까지 한 번에 알아보세요.

LLMOps (대규모 언어 모델 운영) 란?

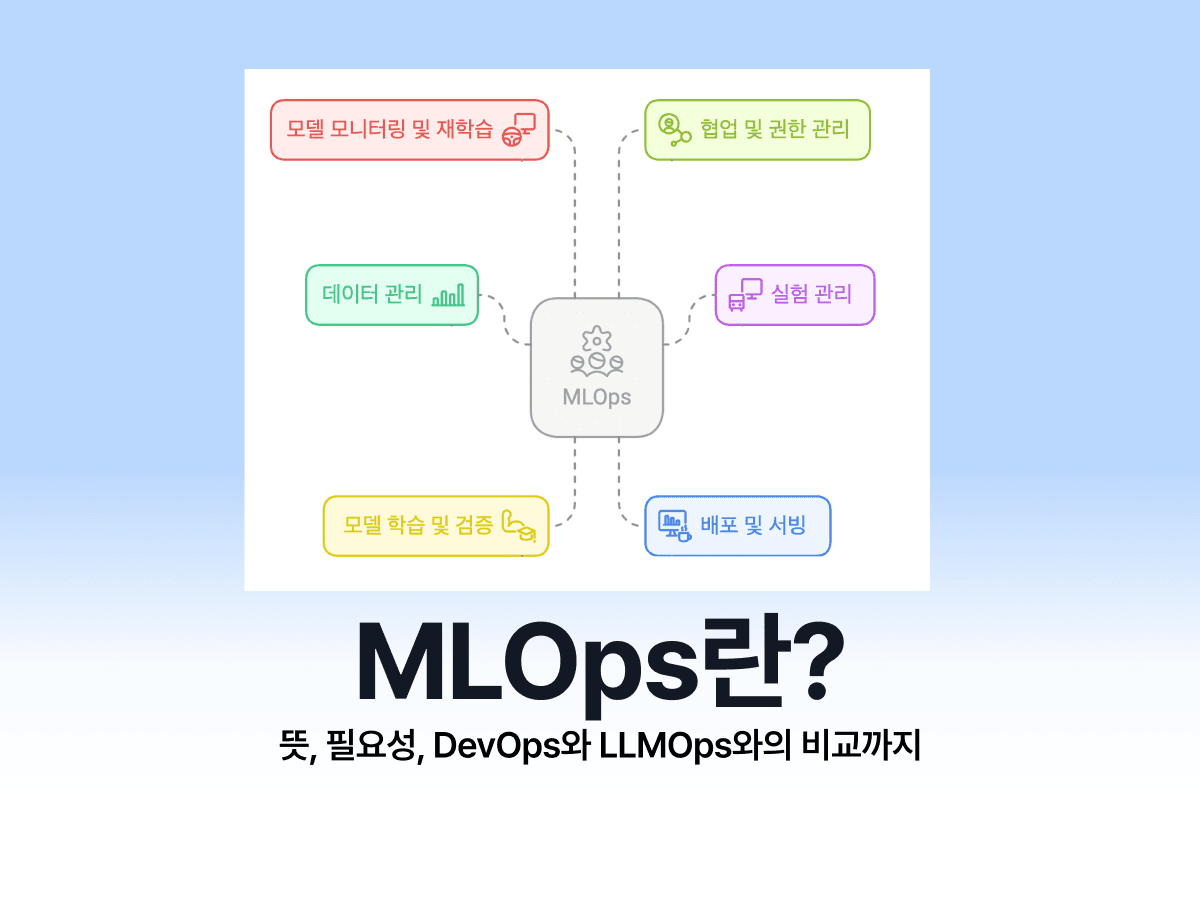

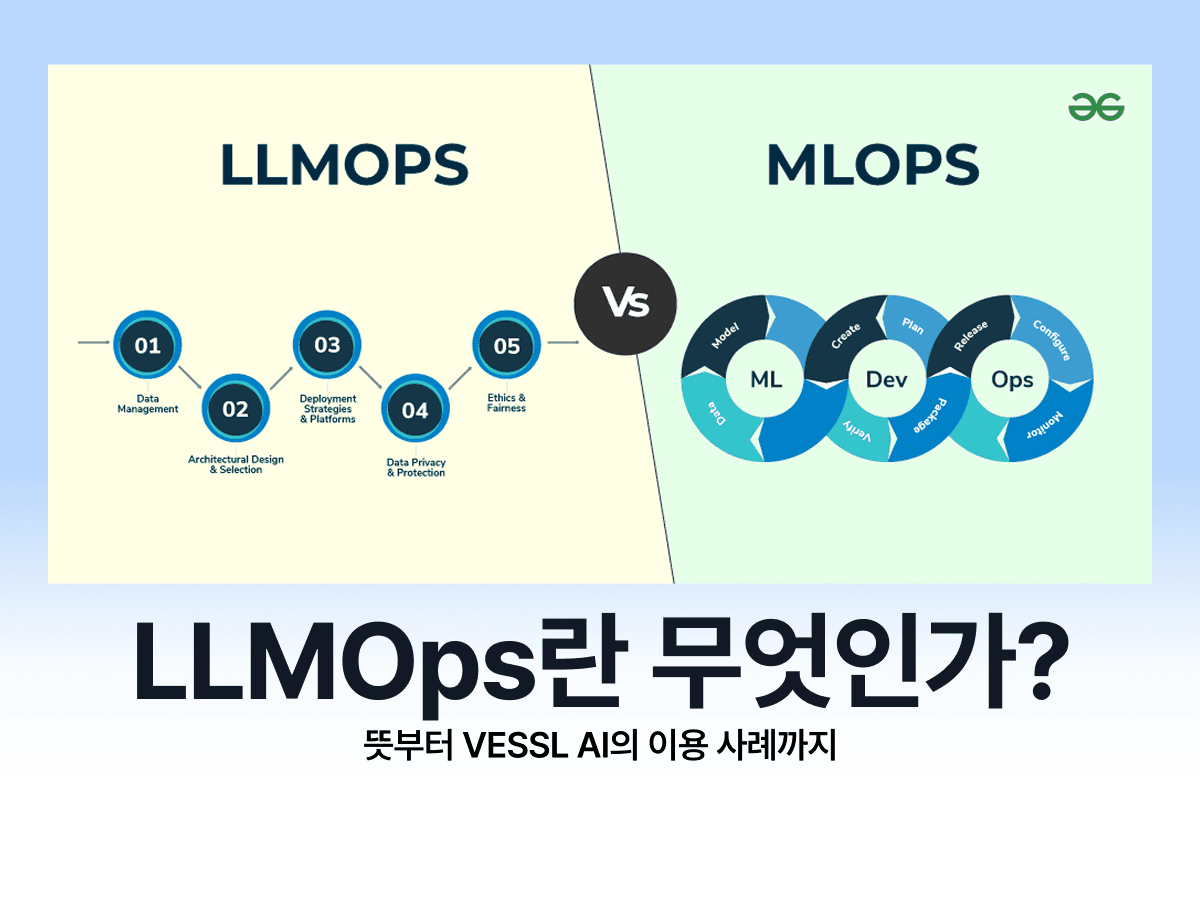

LLMOps란 LLM(대규모 언어 모델)과 Operations(운영)을 합친 말로, LLM 기반 시스템을 개발, 배포, 관리, 최적화하는 전체 워크플로우를 체계화한 운영 전략입니다. LLMOps는 기존 AI 운영 전략인 MLOps를 LLM에 맞게 확장한 개념으로 볼 수 있습니다.

여기서 LLM(Large Language Model, 대규모 언어 모델)은 많은 양의 텍스트 데이터를 학습하여 자연어를 이해하고 생성하는 인공지능 모델을 뜻합니다.

LLMOps의 구성 요소 6가지

LLMOps의 구성 요소는 6가지로, 데이터 수집 & 탐색, 데이터 준비 및 최적화, 모델 개발 및 응답 최적화, 모델 배포, 모니터링 & 검증, 유지보수 & 반복 개선입니다.

데이터 수집 & 탐색 (Data Ingestion & EDA)

LLMOps는 데이터 수집 및 탐색 부터 시작합니다. 이 단계는 모델 개발뿐 아니라, 나중에 모델 모니터링 중 머신러닝 모델이 학습한 데이터와 실제 운영 환경에서 들어오는 데이터 간의 차이 (드리프트)가 발생했을 때에도 재수행될 수 있습니다.

데이터 수집

웹, 내부 데이터베이스, 문서 등 다양한 출처로부터 데이터를 확보.

데이터 정제 및 분석

오류와 중복 제거, 이상치 탐색, 데이터 특성 파악.

데이터 준비 및 최적화

데이터 전처리

토큰화(Tokenization), 포맷 변환, 벡터화 등을 수행.

프롬프트 엔지니어링

데이터 준비 과정에서 목적에 맞는 프롬프트 설계 및 실험을 통해 최적화. 때때로 프롬프트는 파인튜닝을 대체하거나 보완할 수 있음.

모델 개발 및 응답 최적화

상황에 따라 기초 모델 + 프롬프트 조합만으로 충분할 수 있기에, 파인튜닝은 필수는 아니지만 고품질 응답이 필요할 경우에 진행합니다.

기초 모델 선택

GPT, Claude 등 상용 또는 라마(LlamA) 등 오픈소스 모델 선정.

파인튜닝 / RLHF / RAG 등

도메인 특화 튜닝, 강화학습 피드백, 검색 기반 응답 연결.

모델 배포 (Deployment)

모델 배포 단계는 AI 프로젝트에서 개발한 모델을 실제 서비스에 적용하는 단계입니다. 즉, 지금까지 개발 환경에서 잘 작동하던 모델을 실제 운영 환경에서 고객이나 사용자가 쓸 수 있도록 만드는 과정입니다.

서빙

API 엔드포인트 구축, 실시간/배치 대응.

경량화

프루닝(Pruning), 양자화 (Quantization), 지식 증류 (Knowledge distillation) 등을 통해 인퍼런스 성능 및 비용 최적화.

모니터링 & 검증 (Monitoring & Evaluation)

모니터링 및 검증은 모델 배포 이후에 지속적으로 이루어집니다.

성능 관찰

응답 품질, 지연, 비용, 토큰 사용 등 성능 지표 모니터링.

모델 드리프트 감지

데이터 분포 변화나 성능 저하 감시.

유지보수 & 반복 개선 (Maintenance & Iteration)

재훈련

신규 데이터 반영, 모델 리파인(refine).

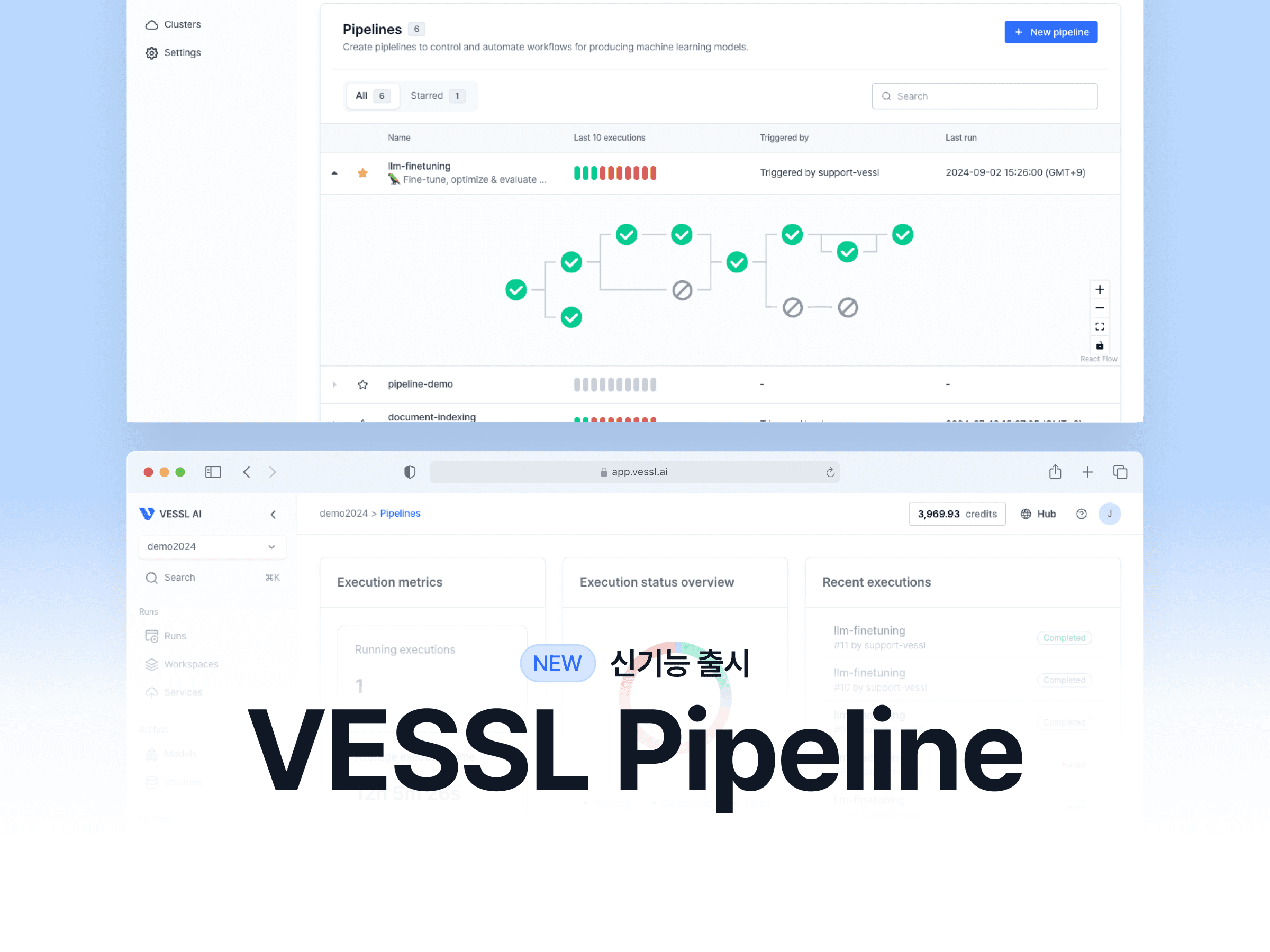

파이프라인 자동화

CI/CD, 재배포, 자원 관리 자동화로 성숙한 운영 환경 구축.

LLMOps의 장점

LLMOps의 장점은 4가지로, 효율성, 확장성, 보안성, 투명성이 있습니다.

효율성

LLMOps를 도입하면 모델을 더 빠르게 개발하고, 손쉽게 배포할 수 있습니다. 또한 LLM(대규모 언어 모델)의 응답 품질이나 작동 정확도 등을 지속적으로 개선할 수 있어 전반적인 운영 효율이 높아집니다.

확장성

LLMOps 플랫폼은 하나의 모델뿐 아니라 여러 개의 LLM 모델을 함께 관리할 수 있도록 도와줍니다. 새로운 기능 추가나 모델 업데이트가 있을 때도 자동으로 시스템에 안정적으로 반영되기 때문에, 기업 규모나 사용량이 커져도 유연하게 대응할 수 있는 환경을 제공합니다.

보안성 / 투명성

LLMOps는 데이터 암호화, 접근 제어, 감사 로그 등을 통해 민감 데이터와 모델을 안전하게 보호합니다. 또한 LLMOps 플랫폼을 이용하면 모델의 예측 과정과 결과에 대한 추적 및 설명 가능성을 높여 규제 준수와 신뢰성을 확보합니다.

LLMOps와 RAG, 어떻게 다를까?

LLMOps와 RAG 모두 대규모 언어 모델(LLM)을 잘 활용하기 위한 기술이지만, 그 목적과 역할은 분명히 다릅니다.

앞서 말씀드렸듯이 LLMOps가 모델을 안정적으로 배포·관리·운영하기 위한 체계적인 방법론이라면, RAG란 LLM의 한계를 보완하기 위한 기술로, LLM이 외부 데이터베이스나 문서에서 정보를 찾아보고 그 결과를 반영해 답변하도록 만드는 방식입니다. 즉, LLMOps는 전체 LLM 시스템을 구축·운영하는 기반, RAG는 그 시스템 안에서 정보 정확도를 높이는 기능 중 하나입니다.

LLMOps 플랫폼 이용 사례 / 예시

비즈니스 의사결정을 돕는 LLMOps 플랫폼 사례

LLMOps 도입 배경

한 비트코인 마이닝 기업은 시장에서 빠르게 변하는 가격, SNS 이슈, 경쟁사 공시를 놓치지 않기 위해 관련 데이터를 모아 분석하고, 즉시 의사결정에 활용하고 싶었습니다. 하지만 데이터를 수집·분석·보고하는 데 시간이 너무 많이 걸리고, AI 파이프라인을 직접 구축·운영하기에는 부담이 컸습니다.

LLMOps 활용 방법

- 데이터 자동 수집·정리: 뉴스, 공시, SNS 데이터를 실시간으로 DB에 업데이트

- RAG 기반 LLM 챗봇: 최신 데이터를 활용해 질문에 정확히 답변

- 자동 알림: 중요 이슈 발생 시 즉시 담당자에게 알림

- 성능 모니터링·자동 롤백: 문제 발생 시 자동으로 이전 상태로 복구

LLMOps 도입 결과

- 시장 변동에 즉시 대응 가능

- 보고서 작성 시간이 수 주 → 수 일로 단축

- AI 엔지니어 없이도 쉽게 운영

- 운영 비용과 인력 시간을 절약해 빠르고 정확한 의사결정 가능

직원 교육부터 고객 응대 챗봇까지, 비즈니스 확장 돕는 AI 솔루션을 만드는데 베슬에이아이의 VESSL 플랫폼이 어떻게 활용될 수 있는지 더 알아보려면 이 글을 참고해 주세요.

LLMOps 기반 멘탈헬스 AI 챗봇 이용 사례

LLMOps 도입 배경

한 멘탈헬스 기업은 사용자의 감정·스트레스 상태를 기록하고 즉시 조언해주는 AI 코칭 챗봇을 만들고 싶었습니다. 하지만 상담사가 모든 데이터를 직접 확인하기 어려워 대기가 길어졌고, 민감한 개인정보를 안전하게 처리하면서도 빠르게 운영할 방법이 필요했습니다.

LLMOps 활용 방법

- 온프레미스 Private LLM 챗봇 구축 → 민감 데이터 보호

- RAG 기반 맞춤형 상담 → 코칭 자료·심리 문헌 참고해 정확한 답변 제공

- 자동화 파이프라인 → 실시간 피드백 반영 및 지속적 모델 개선

LLMOps 도입 결과

- 사용자는 24시간 즉시 AI 코칭을 받아 심리적 부담 완화

- 상담사 인력 부담 감소, 업무 효율 상승

- 규제 부담을 줄인 코칭 서비스 형태로 시장 진입 용이

- 사용자 만족도와 재방문율 상승, 구독 모델 확장 가능

멘탈헬스 AI 챗봇 솔루션 구축에 베슬에이아이의 VESSL 플랫폼이 어떻게 쓰일 수 있을지 더 알아보려면 이 글을 참고해 주세요.

빠르게 변화하는 AI 시장에서 LLMOps는 기업이 LLM을 실무에 안정적으로 적용하고 운영하는 데 핵심인 기술입니다. VESSL AI는 LLMOps 플랫폼 구축부터 LLMOps 운영 자동화까지 풀스택으로 지원하여, 기업이 AI 업무 자동화를 안전하고 효율적으로 실현할 수 있도록 돕고 있습니다.

프라이빗 LLM 및 AI 에이전트 기반 업무 자동화, RAG 기반 챗봇 구축 등 LLMOps 도입을 고민하고 있다면, 지금 VESSL AI 팀에 문의해 보세요!

Alice Lee

Growth Manager

Kate Kim

Growth Manager

Try VESSL today

Build, train, and deploy models faster at scale with fully managed infrastructure, tools, and workflows.