제품 업데이트

25 September 2024

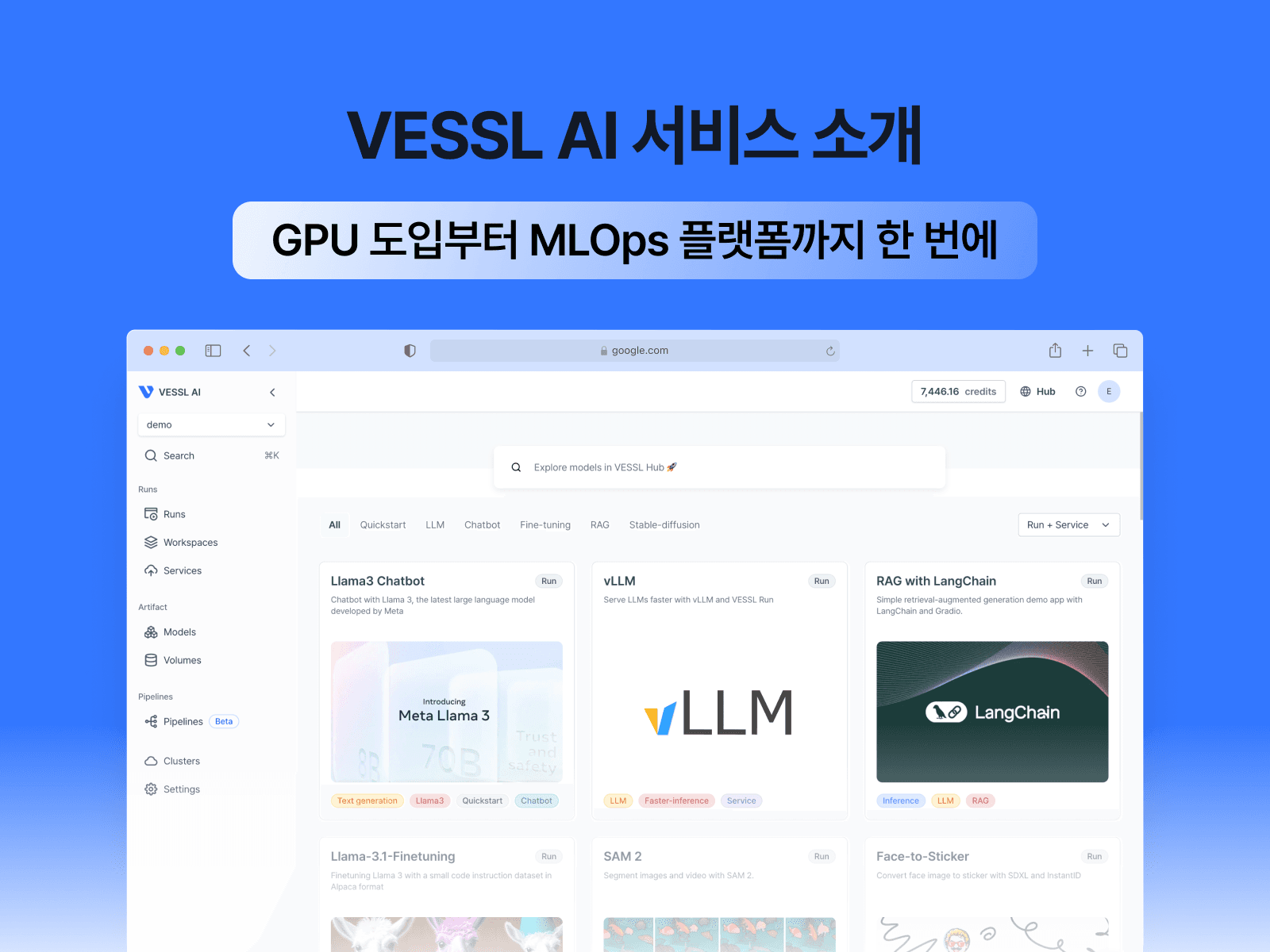

MLOps 플랫폼 VESSL - 파이프라인(Pipeline) 기능 출시

베슬에이아이에서 복잡한 머신러닝 워크플로우를 파이프라인으로 쉽게 정의하고 관리할 수 있는 파이프라인을 출시했습니다.

VESSL 파이프라인(Pipeline) 이란?

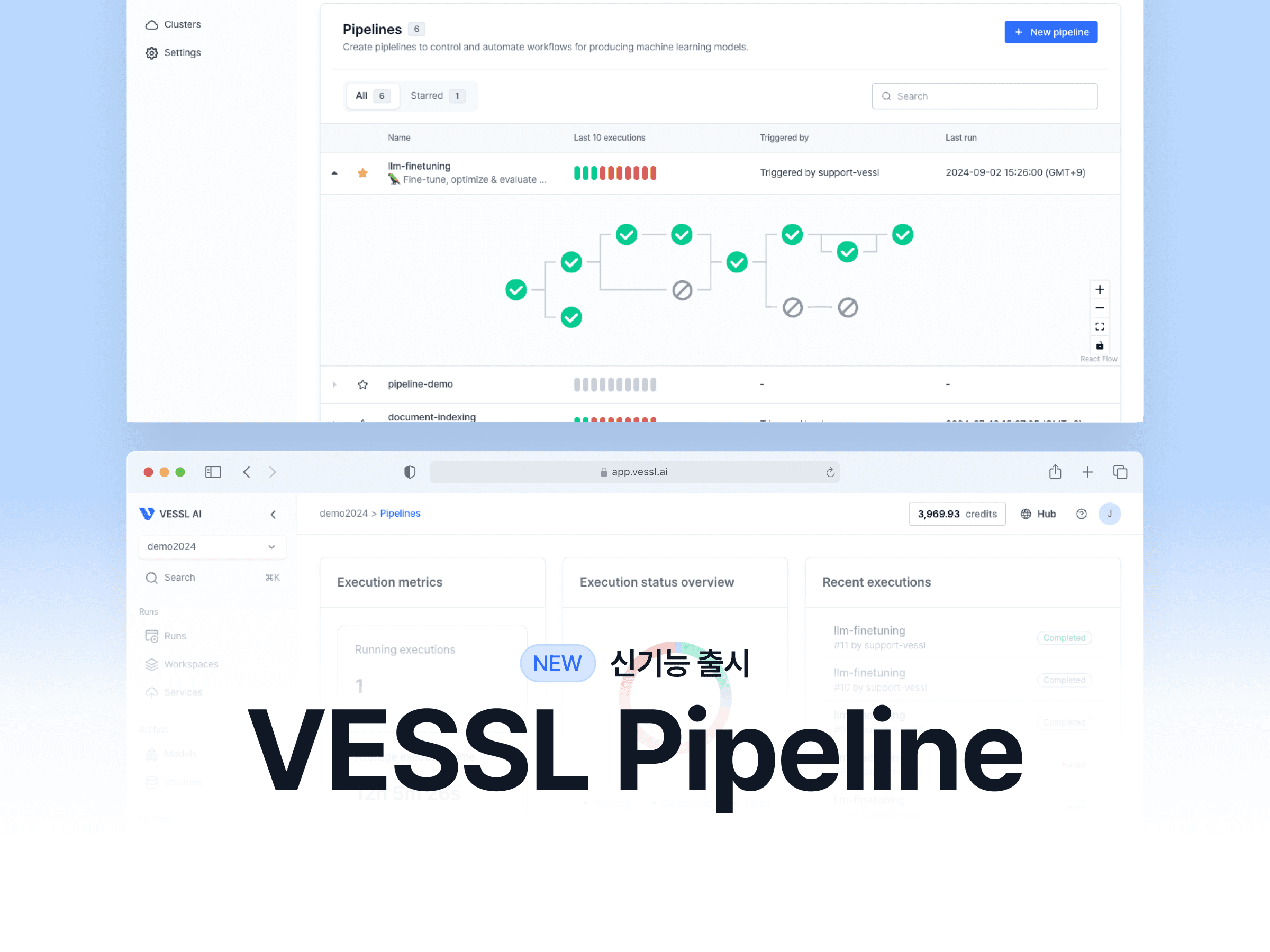

베슬에이아이(VESSL AI)팀이 사용자가 복잡한 머신러닝 워크플로우를 파이프라인으로 쉽게 정의하고 관리할 수 있는 새로운 기능인 VESSL 파이프라인을 출시했습니다. 이 기능은 방향성 비순환 그래프(DAG)를 활용하여 재현 가능하고 일관성 있는 AI 워크플로우를 구현함으로써 복잡한 머신러닝 작업을 처리하는 방식을 간소화합니다. AI/ML 워크플로우 오케스트레이션에 관심이 있으시다면 지금 살펴보세요.

VESSL 파이프라인(Pipeline) 출시 배경

AI 워크플로우를 자동화하는 것은 어려운 일입니다. AI/ML 프로젝트는 본질적으로 데이터 전처리부터 모델 배포까지 여러 단계로 구성되며, 각 단계마다 복잡성이 존재합니다. 이러한 단계를 수동으로 관리하면 시간이 많이 걸리고 오류가 발생하기 쉽습니다.

아래와 같은 문제들을 해결하기 위해 VESSL 파이프라인을 출시했습니다.

1. ML 워크플로우의 복잡성

ML 워크플로우에는 데이터 전처리, 모델 훈련, 평가 및 배포와 같은 여러 단계가 포함됩니다. 이러한 단계를 수동으로 조정하면 비효율성과 실수가 발생할 수 있습니다.

2. 재현성 부족

일관되지 않은 설정이나 환경으로 인해 실험 결과를 공유하거나 실험을 반복하는 데 어려움을 겪는 경우가 많아 AI/ML 프로젝트 결과의 신뢰성이 떨어집니다.

3. 제한된 가시성

사용자는 종종 ML 워크플로우의 투명성 부족으로 어려움을 겪습니다. 파이프라인이 실패하거나 예상치 못한 결과를 생성하는 경우 적절한 도구가 없으면 정확한 문제를 파악하기가 어려울 수 있습니다.

워크플로우의 각 단계에 대한 가시성을 높여 디버깅과 최적화를 보다 쉽게 수행할 수 있어야 합니다. 이러한 문제를 해결하고 복잡한 워크플로우를 보다 간단하고 협업적으로 관리하기 위해 VESSL 파이프라인을 만들었습니다.

VESSL 파이프라인(Pipeline)의 특징

VESSL 파이프라인은 사용자가 복잡한 머신 러닝 워크플로우를 손쉽게 정의하고 관리할 수 있도록 다양한 기능과 이점을 제공합니다:

1. YAML 및 DAG 시각화를 통한 파이프라인 구성

YAML 파일을 사용하거나 사용자 친화적인 드래그 앤 드롭 UI를 통해 단계를 방향성 비순환 그래프(DAG)로 구성하는 파이프라인을 생성 및 수정할 수 있습니다.

이 기능은 복잡한 워크플로도 쉽게 이해할 수 있는 형식으로 표시하여 광범위한 코딩의 필요성을 줄여줍니다.

재현성 및 협업: 파이프라인 구성 및 실행 이력이 자동으로 저장되어 팀원들과 쉽게 공유하고 협업할 수 있습니다. 이를 통해 실험을 재현할 수 있고 프로젝트의 일관성을 유지할 수 있습니다.

2. 향상된 디버깅

각 단계에 대한 자세한 모니터링 및 로깅을 통해 사용자는 워크플로우에 대한 명확한 인사이트를 얻을 수 있습니다. 이러한 투명성을 통해 문제를 더 빠르게 식별하고 해결할 수 있어 모델 개발의 효율성이 향상됩니다.

VESSL 파이프라인(Pipeline) 사용 방법

다음은 VESSL 파이프라인 사용 방법에 대한 간단한 가이드입니다.

1. VESSL의 파이프라인 메뉴에 들어갑니다.

VESSL에 로그인하고 사이드바로 이동합니다.

파이프라인 대시보드의 사이드바에서 파이프라인 메뉴를 클릭합니다.

파이프라인 소개

2. 새 파이프라인을 생성합니다.

새 파이프라인 만들기 버튼을 클릭하여 새 파이프라인을 시작합니다.

새 파이프라인 만들기

쉽게 식별할 수 있도록 파이프라인의 이름과 설명을 입력하세요.

파이프라인 만들기

3. 파이프라인 단계와 변수를 정의합니다.

파이프라인에 필요한 단계를 추가하고 각 단계에서 실행할 작업을 지정하세요.

단계 간 종속성을 설정하여 실행 순서를 제어할 수 있습니다.

파이프라인 변수를 정의하여 데이터 경로 및 환경 변수와 같은 값을 관리하세요.

파이프라인 단계 정의

4. 파이프라인을 실행하고 모니터링합니다.

파이프라인 실행 버튼을 클릭하여 파이프라인을 실행합니다.

대시보드에서 파이프라인의 진행 상황과 상태를 실시간으로 모니터링하세요.

파이프라인 실행 및 모니터링

VESSL 파이프라인(Pipeline) 업데이트 예정 항목

VESSL AI는 사용자 피드백을 바탕으로 파이프라인 기능을 지속적으로 개선하고 확장하기 위해 최선을 다하고 있습니다. 향후 업데이트 예정 항목은 다음과 같습니다.

1. 모니터링 및 알림 기능

실시간 모니터링 및 알림 기능을 강화하여 파이프라인 실행 중 발생하는 모든 문제에 신속하게 대응할 수 있도록 합니다.

2. 가시성 및 디버깅 도구

보다 상세한 로그, 시각화 및 진단 도구를 제공하여 디버깅을 더욱 효율적으로 수행할 수 있습니다.

3. 사용자 경험

보다 직관적인 인터페이스를 위해 UI/UX를 개선하고 포괄적인 교육 자료와 튜토리얼을 제공합니다.

Wayne Kim

Product Marketer

Jay Chun

CTO and CISO

Try VESSL today

Build, train, and deploy models faster at scale with fully managed infrastructure, tools, and workflows.