제품 업데이트

26 March 2025

[베슬에이아이] NVIDIA NIM·NeMo 통합! 엔터프라이즈 AI 모델 운영 역량 강화

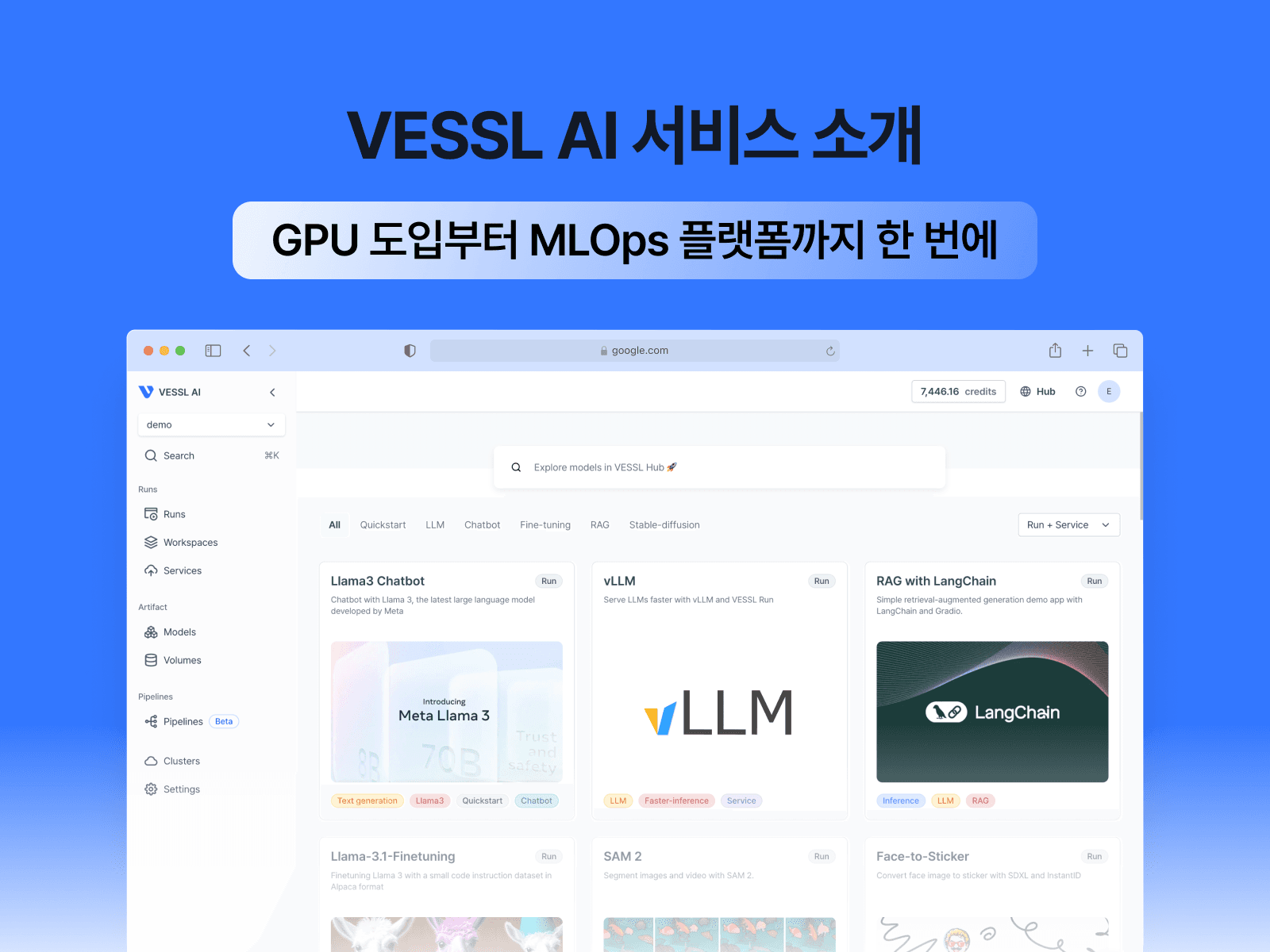

NIM Container를 활용해 모델 성능의 최적화 과정을 간소화하고 API로 배포 시간을 단축해 보세요. NeMo Curator 등의 도구로도 사용자 맞춤화하고 Private LLM을 학습할 수 있습니다.

![[베슬에이아이] NVIDIA NIM·NeMo 통합! 엔터프라이즈 AI 모델 운영 역량 강화](/_next/image?url=https%3A%2F%2Fcdn.sanity.io%2Fimages%2Fbqtfzw22%2Fproduction%2F0798d808086d56cb074b7a05d3a167d810871b01-1600x1200.png&w=3840&q=75)

이제는 정말 많은 엔터프라이즈 기업들이 AI 이니셔티브를 확대하며, 사용자 경험을 개선하거나 내부 프로세스를 개선하여 성과를 내고 있습니다. 조직 내에서 관리해야할 AI 모델의 수가 늘어날수록 엔터프라이즈 고객은 AI 모델의 성능과 효용 뿐만 아니라, (1) 비용, (2) 레이턴시, (3) 컴플라이언스 문제 등을 마주하게 되는데요.

베슬에이아이(VESSL AI)는 엔비디아의 NIM과 NEMO 도구를 제품에 통합해, 엔터프라이즈 환경에 최적화된 AI 모델 배포 역량과 Private LLM 구축 역량을 강화했습니다.

- 이제 VESSL MLOps 플랫폼에서도 NIM 컨테이너를 활용해 이전보다 더 적은 비용으로 모델 성능을 최적화하는 과정을 간소화할 수 있고, API를 통해 배포 시간을 단 몇 분 이내로 단축할 수 있습니다. 자체 서버 환경에서도 구동할 수 있어 개인정보 보호 및 보안 규정을 지킬 수 있습니다.

- 또한 NeMo Curator 등의 도구를 활용해, LLM 학습에 필요한 합성 데이터 세트를 구성하거나 유해 답변을 차단하는 등 사용자 맞춤화하고, 내부적인 기준에 맞는 Private LLM을 학습할 수 있습니다.

NVIDIA NIM 마이크로 서비스를 활용한 손쉬운 LLM 애플리케이션 구축

엔비디아 NIM은 AI 모델을 쉽고 빠르게 배포하고 운영할 수 있도록 설계된 마이크로 서비스입니다. 기존에는 AI 모델을 서비스하기 위해 복잡한 환경 설정과 최적화 작업이 필요했지만, NIM을 사용하면 한 줄 명령어만으로 바로 실행할 수 있습니다. 또한 모델 종류와 GPU 조합마다 최적화가 사전 적용되어 있어, 사용자가 별도로 튜닝하지 않아도 모델별로 최상의 성능을 발휘합니다.

엔터프라이즈 고객이 NIM을 활용하면, 아래와 같이 5가지의 이점을 얻을 수 있습니다.

- 성능 최적화 : TensorRT 기반 최적화로 최저 지연시간, 최대 토큰 처리량을 제공합니다.

- 배포 속도 및 편의성 : 사전에 최적화된 컨테이너를 활용해, 명령어 한 줄 만으로 즉시 배포가 가능합니다.

- 확장성 : 온프레미스, 클라우드에 관계없이 기업 고객이 자신의 인프라 환경에서 다수의 인스턴스를 배포하거나 필요에 따라 스케일링할 수 있습니다.

- 비용 효율성 : 하드웨어 자원 활용도를 극대화하여 동일한 작업을 적은 GPU로 처리할 수 있도록 지원합니다.

- 지원하는 AI 모델 : 최신 LLM/VLM(Meta llama-3, Google Gemma, Mistral Large) 등 40개 이상의 엔터프라이즈 급의 모델을 지원합니다.

이를 통해 AI 지식 없이도 코파일럿, 챗봇 등의 AI 애플리케이션을 몇 주가 아닌 단 몇 분만에 손쉽게 구축할 수 있습니다. VESSL Hub의 Service 템플릿에서 NIM을 즉시 활용하실 수 있습니다.

NVIDIA NeMo Curator 를 활용한 비용 효율적인 합성 데이터 생성

좀 더 고도화된 니즈를 가지고 있는 기업 고객은 NVIDIA NeMo를 활용하여, 자체적인 대규모 언어 모델(LLM)을 구축하고 맞춤화 할 수 있습니다.

엔비디아의 NeMo Curator, Customizer, Evaluator, Retriever, Guardrails, NIM 등 6가지 도구를 통해서 데이터 준비 부터 파인튜닝, 배포까지 Private LLM 구축에 필요한 전 과정을 지원합니다. 각각의 솔루션을 LLM 학습 및 운영 파이프라인 상에서 기업에 리스크가 될 수 있는 요소를 줄이고, 성능 및 비용 차원에서 최적화된 자체 모델을 구축할 수 있습니다.

베슬에이아이(VESSL AI)는 6개의 도구 중 NeMo Curator를 우선적으로 적용했습니다. 많은 기업 고객이 파인튜닝하는 과정에서 데이터가 충분하지 않아 Private LLM을 구축하는 데에 어려움을 겪는데요, NeMo Curator를 이용하면, 비용 효율적으로 합성 데이터를 생성하고 학습에 이용할 수 있습니다.

베슬에이아이의 VESSL 플랫폼에서 NVIDIA NIM & NEMO Curator를 이용하는 방법

베슬에이아이(VESSL AI)의 VESSL 플랫폼 내에서 NIM & NEMO를 손쉽게 이용하려면, Hub 에 구축된 템플릿으로 간단히 시작해 보세요. Run 또는 Service 기능에서 GUI 만으로 Llama 3.1을 포함한 다양한 LLM 모델을 간단히 배포할 수 있습니다.

나아가, VESSL Pipeline 기능에서 일련의 배포 및 운영 과정에 NeMo를 적용하여 파이프라인을 구성할 수 있습니다.

엔비디아의 NIM을 통해 Llama-3.1-8B-Insturct을 배포하는 예시를 통해, 사용 방법을 더 자세히 설명하겠습니다.

Step 1. NGC API key 혹은 필요하다면 LLM API Key 를 사전에 준비하세요.

만약 NGC API Key 가 없다면, NVIDIA Documentation 의 가이드를 따라 생성해야 합니다.

Organization Setting 페이지의 Intergrations 탭에서 Docker Credential 추가

- Credential name : ngc-credential

- ID : $oauthtoken

- Password : 생성한 NGC API 키 입력

Organization Setting 페이지의 secrets 탭에서 secret 추가

- Secret name : ngc-api-key

- Secret value : 생성한 NGC API 키 입력

Step 2. VESSL Hub에서 Nvidia NIM 또는 Nvidia NeMo Curator 템플릿을 선택합니다.

Step 3. 우측 상단의 버튼을 눌러 Orgazation과 Service 종류를 선택한 뒤 템플릿을 실행합니다.

Step 4. GUI를 통해 작성된 YAML 파일을 확인한 뒤, 수정 혹은 실행합니다.

앞으로 Curator 이외에 엔비디아의 NeMo 도구들을 순차적으로 지원할 예정이며, 일련의 파인튜닝 과정을 손쉽게 적용해볼 수 있도록 사전 구축된 파이프라인 템플릿을 준비중이니, 많은 기대 부탁드립니다.

Eugene

Product Manager