고객 사례

11 July 2025

서울대학교 공과대학, MLOps 플랫폼 VESSL 도입으로 GPU 자원 운영 효율화와 연구 생산성 향상을 동시에 잡다

[베슬AI 고객 사례] 서울대학교 공과대학의 이야기를 통해 MLOps 플랫폼 VESSL의 효과를 확인해 보세요!

서울대학교 공과대학은 AI·머신러닝 실험을 위한 고성능 GPU 클러스터를 다수 보유하고 있으며, 최근 VESSL AI의 MLOps 플랫폼 ‘VESSL’을 도입하여 GPU 자원 관리 및 연구 환경 운영 효율성을 대폭 향상시켰습니다.

서울대학교 공과대학은 어떤 이유로 베슬에이아이의 VESSL 플랫폼을 선택했고, 어떤 효과를 경험했을까요? 공과대학 정보화지원실 조교로 근무했던 서용훈님의 이야기를 통해 확인해 보세요!

서울대학교가 VESSL 플랫폼을 도입하게 된 계기

서울대학교 공과대학은 NVIDIA A100 및 GTX 1080 GPU 기반의 클러스터를 직접 보유하고 있으며, AI/ML 연구를 위해 이를 학내 연구팀과 대학원생들에게 제공해 왔습니다. 하지만 기존의 자원 관리 방식에는 여러 한계가 있었습니다.

VESSL 도입 전, 서울대학교 공과대학이 겪었던 자원 관리의 어려움

1. 번거로운 자원 할당 방식

: GPU 자원은 관리자에 의해 수동으로 도커 컨테이너를 생성하고, 사용자별로 접속 정보를 개별 전달해야 했습니다. 이 과정은 시간이 오래 걸리고 관리가 어려웠습니다.

2. 복잡한 사용 절차 및 비전문가가 접근하기 어려운 환경

: 클러스터를 사용하려면 사용자들이 SSH 접속, CLI 기반 환경 설정 등을 직접 수행해야 했고, MLOps 경험이 없는 연구자에게는 진입 장벽이 높았습니다.

3. 자원 관리의 비효율성

: GPU 자원 점유 시간이 불분명하거나 회수가 지연되는 경우, 전체 사용 효율이 낮아지고 중요한 실험이 미뤄지는 일이 반복되었습니다.

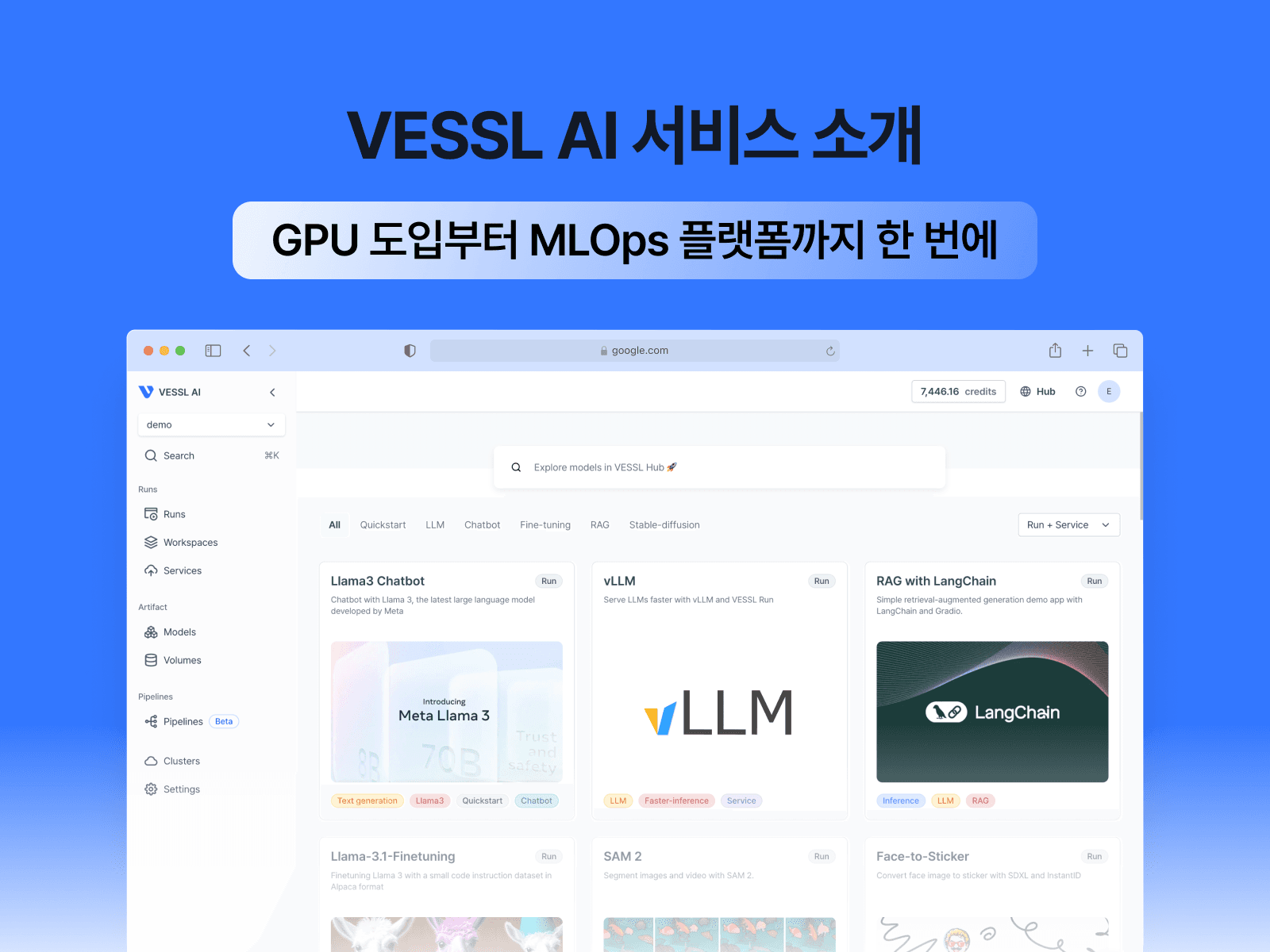

VESSL 플랫폼 도입 후, 서울대학교 공과대학이 체감한 변화

서울대학교는 이러한 문제를 해결하기 위해 VESSL 플랫폼을 클러스터 운영에 도입했습니다. 특히 VESSL의 웹 기반 클러스터 관리 기능은 복잡한 설정 없이도 클러스터 현황을 직관적으로 파악할 수 있도록 해주었습니다.

VESSL의 클러스터 관리 기능이 서울대학교 공과대학에 가져다준 주요 변화 4가지

1. 시각화된 클러스터 모니터링 환경

: 웹 애플리케이션에서 쿠버네티스(Kubernetes)에 대한 사전 지식 없이도 클러스터의 workload와 가용 GPU 자원을 한눈에 파악할 수 있었습니다. 그라파나(Grafana) 같은 별도 툴 없이도 운영이 가능해졌죠.

2. GPU 자원의 효율적인 관리

: DGX A100 클러스터에 대해 점유 가능한 GPU 수와 시간 제한을 설정하고, GPU를 대량으로 사용하는 실험은 별도 워커 노드를 전용으로 할당해 자원의 효율성을 극대화했습니다.

3. 간편한 실험 실행으로, 누구에게나 쉬운 접근성

: CLI나 복잡한 설정 없이도 클릭 몇 번으로 실험을 실행할 수 있었고, 필요시 YAML 기반 세부 설정도 가능해 초급자부터 전문가까지 모두가 유연하게 사용할 수 있었습니다.

4. 연구에 최적화된 사용자 경험

: Jupyter Notebook과 persistent 스토리지가 통합된 workspace를 통해, 연구자들이 자신의 작업 환경을 그대로 유지하며 실험을 이어갈 수 있게 되었습니다.

관리자 입장에서 바라본 VESSL 플랫폼의 장점

서용훈 조교는 “미리 구성해둔 커스텀 이미지를 통해 원하는 환경을 신속하게 구성할 수 있었고, 반복적인 설정 작업 없이 연구에 집중할 수 있었다”고 전했습니다.

또한, VESSL Run을 통해 간단한 작업만으로도 환경 구성, 자원 할당, 결과 확인까지 이어지는 자동화된 워크플로우를 경험할 수 있었으며, 필요한 경우 YAML 파일을 직접 수정해 더 정밀한 작업도 가능했습니다.

VESSL 플랫폼, 다른 대학·연구기관에도 추천합니다

“복잡한 환경 설정 없이도 고성능 자원에 손쉽게 접근할 수 있다는 점에서 VESSL은 매우 훌륭한 도구입니다. 연구자가 연구에만 집중할 수 있는 환경을 만들어주니까요.” - 서용훈 조교

서울대학교처럼, VESSL AI의 MLOps 플랫폼을 통해 클러스터 자원 운영을 자동화하고, 연구 효율을 높여보세요.

AI/ML 인프라 운영에 부담을 느끼고 있다면, 지금 바로 VESSL AI 팀에 문의해 주세요!

Kate Kim

Growth Manager

Try VESSL today

Build, train, and deploy models faster at scale with fully managed infrastructure, tools, and workflows.