인사이트

기업이 AI를 운영하기 위해 알아야 할 10가지

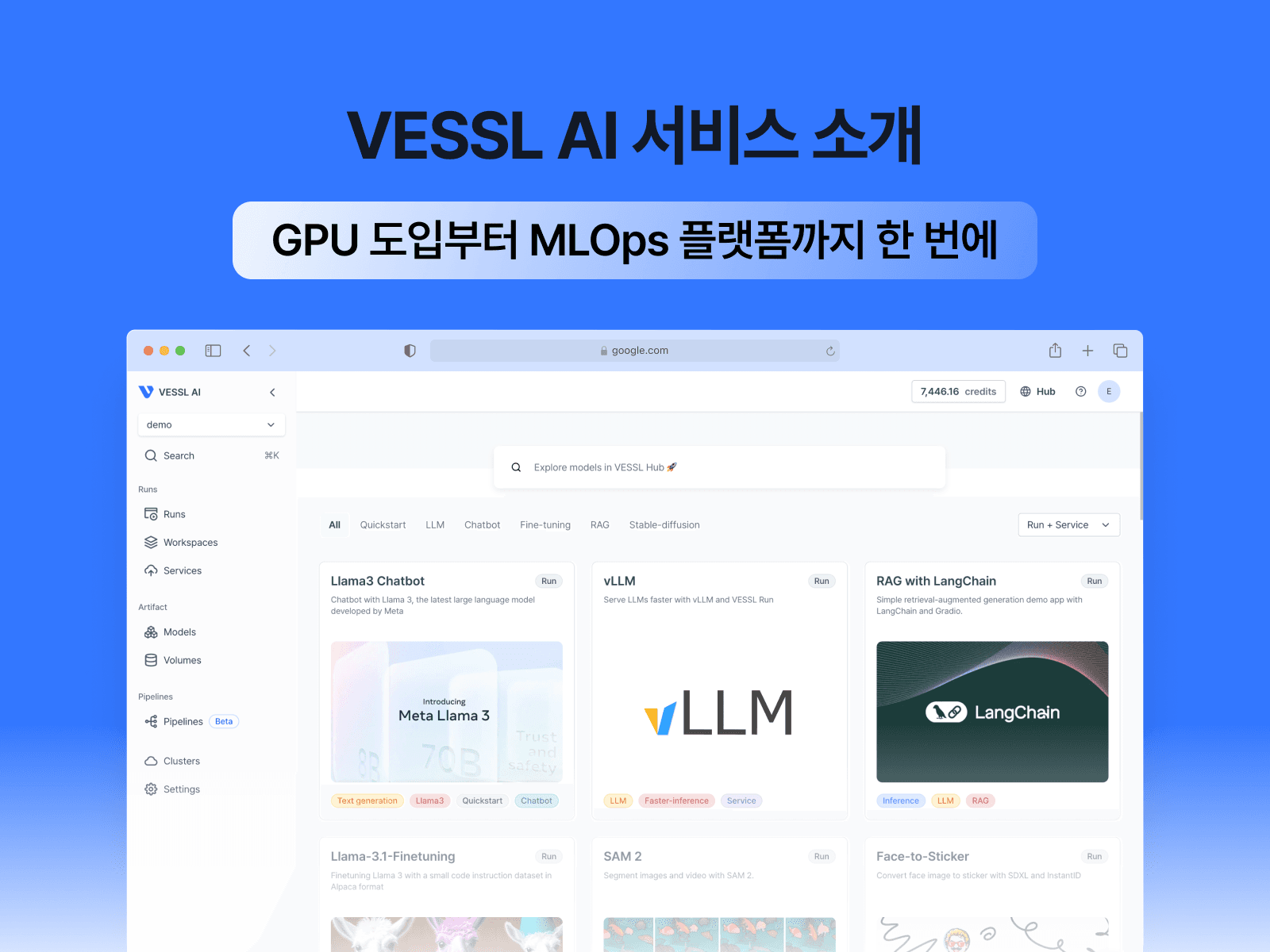

VESSL AI에서 AI 운영을 위해 알아야 할 필수 요소에 대해 알아봐요.

기업이 AI 모델 운영 시 꼭 알아야 하는 10가지

인공지능(AI)을 도입하는 기업들이 많아졌지만, AI 모델을 실제 운영에 안착시키는 과정에서 공통적으로 복잡한 문제에 직면하고 있습니다. 한 글로벌 조사에 따르면 머신러닝 프로젝트의 절반 이상이 시범 단계(PoC)를 넘어서지 못하고 운영 환경 도입에 실패한다고 합니다. 이는 뛰어난 모델을 개발하는 것보다도 모델을 제품과 업무에 통합하고 안정적으로 운영하는 데 더 큰 어려움이 따른다는 사실을 보여줍니다. 실제로 AI/ML 시스템에서는 모델 코드는 전체 시스템의 일부에 불과하며, 나머지는 데이터 수집·처리, 인프라, 통합, 모니터링 등 복잡한 지원 요소들로 구성되어 있습니다.

출처: McKinsey & CompanyMLOps so AI can scale

맥킨지(McKinsey)도 ML 개발 실패의 90% 이상이 모델 자체의 문제가 아니라 미흡한 제품화 및 운영 환경 통합에 기인한다고 지적합니다. 즉, AI 모델을 제대로 활용하려면 모델 개발 이후의 과정(데이터 파이프라인 구축, 인프라 관리, 배포, 모니터링, 보안 및 거버넌스까지)전반에 걸친 전략이 필요합니다.

이 글에서는 기업이 AI 모델을 운영할 때 꼭 알아야 할 10가지 핵심 사항을 살펴보겠습니다. 각 항목마다 자료와 업계 사례를 바탕으로 실질적인 인사이트를 제공해 드리기 위한 내용을 담았습니다. 이를 통해 AI 모델 운영의 복잡성을 효과적으로 관리하고, 비즈니스 가치를 극대화할 수 있는 전략적 방향을 얻어가시길 바랍니다.

1. 데이터 파이프라인 관리

데이터는 AI의 연료입니다. 고품질의 데이터가 안정적으로 공급되지 않으면 아무리 뛰어난 머신러닝 알고리즘도 제대로 성능을 발휘할 수 없습니다. AI 모델의 예측 정확도와 신뢰성은 학습 및 입력 데이터의 품질에 좌우되며, 데이터가 시시각각 변화하는 현실에서 지속적인 데이터 수집 및 정제와 관리 프로세스가 뒷받침되어야 합니다. 특히 대용량 데이터 환경에선 수동 관리로 한계가 있으므로, 자동화된 데이터 파이프라인이 필수적입니다.

만약 데이터 파이프라인 관리가 부실하면 “Garbage In, Garbage Out” 현상이 발생합니다. 즉, 잘못된 또는 불완전한 데이터가 들어오면 잘못된 의사결정이 나오는 결과를 초래합니다. 데이터가 제때 준비되지 않으면 모델 배포가 지연되고, 데이터 품질 저하나 데이터 드리프트(시간에 따라 데이터 분포가 변하는 현상)를 방치하면 모델 예측 성능이 급격히 떨어질 수 있습니다. 그 결과, 모델이 실제 비즈니스에 가치를 주지 못하고 실패로 끝날 위험이 높아집니다. 한 예로, 금융 거래 모니터링처럼 고속으로 유입되는 데이터의 이상치를 걸러내지 못하면 모델이 오탐지 또는 미탐지 오류를 일으켜 큰 손실을 낳을 수 있습니다. 이러한 결점을 보완하기 위해 견고한 데이터 파이프라인을 구축하면 AI 모델의 정확도와 신뢰성이 크게 향상됩니다. 일관되고 깨끗한 데이터 공급을 통해 모델은 최신 패턴을 학습하고 예측 성능을 유지할 수 있으며, 비즈니스 의사결정의 품질도 개선됩니다.

예를 들어 데이터 품질 검증과 정제를 철저히 한 기업은 모델 예측 오류를 줄이고, 나아가 데이터에서 새로운 인사이트를 발굴하여 경쟁우위를 확보했습니다. 또한 잘 정비된 파이프라인은 새로운 데이터 소스 추가나 기능 변경에도 유연하게 대응할 수 있어, 변화하는 시장 환경에 신속히 적응하는 AI를 구현할 수 있습니다.

먼저, 지속적이며 자동화된 데이터 파이프라인을 구축하는 것이 핵심입니다. 구체적으로는 데이터 수집부터 정제, 특성 엔지니어링까지 모든 단계를 자동화하고, 데이터 품질을 모니터링하여 이상치를 감지하는 도구를 도입해야 합니다.

예를 들어 피처 저장소(Feature Store)와 같은 중앙 관리 시스템을 활용하면 각 모델이 일관된 데이터를 제공받게 되어 “ML 모델의 연료”인 피처를 안정적으로 공급할 수 있습니다. 또한 데이터 스키마와 메타데이터를 관리하여 데이터 계보(lineage)를 추적하고, 데이터 버전 관리 및 접근 권한 제어를 통해 데이터 거버넌스 체계를 강화해야 합니다. 이런 접근을 통해 기업은 필요한 데이터를 필요한 시점에 신뢰성 있게 확보하여 AI 모델의 성능을 극대화할 수 있습니다.

2. MLOps(Machine Learning Operations) 프로세스 구축

출처: McKinsey & CompanyMLOps so AI can scale

MLOps는 개발한 AI 모델을 신속하고 안정적으로 제품화하기 위한 일련의 프로세스와 문화입니다. 효과적인 MLOps를 구축한 기업은 AI 활용 수준을 한 단계 끌어올려, 단순히 몇 가지 실험적 모델을 만드는 것을 넘어 AI를 통한 사업 변혁과 경쟁력 강화를 달성하고 있습니다. 맥킨지에 따르면, MLOps를 도입하느냐의 여부는 “AI 실험으로 그칠 것인가, AI로 비즈니스 판도를 바꿀 것인가의 차이”로 비유될 정도입니다. MLOps를 통해 모델 개발부터 배포, 운영에 이르는 전체 수명주기를 체계화하면 개발 속도가 빨라지고, 품질과 일관성이 향상되며, 다수의 모델을 규모에 맞게 운영할 수 있는 기반이 마련됩니다.

출처: Google CloudMLOps: Continuous delivery and automation pipelines in machi…

MLOps가 정립되지 않으면 우수한 모델도 빛을 보지 못하고 사장될 위험이 큽니다. 실제로 구글은 “진짜 도전은 모델을 개발하는 것이 아니라, 그것을 통합된 시스템으로 만들어 지속 운영하는 것”이라고 밝히며, 운영 단계에서 수많은 복병(pitfall)을 겪을 수 있다고 경고했습니다. 이는 MLOps 없이 모델을 일일이 수동으로 배포하고 관리하면 인적 오류, 재현 불가, 배포 지연, 환경 불일치 등의 문제가 빈발할 수 있다는 의미이기도 합니다. 예컨대 개발 환경에서는 잘 돌아가던 모델이 운영 환경에선 오류를 내거나 성능이 떨어지는 “훈련-배포 격차”(Training-Serving Skew)가 발생하기 쉽습니다.

출처: MLOps as The Key to Efficient AI Model Deployment and Maximum ROI

또한 위 조사에 따르면 MLOps 체계를 갖추지 못한 조직에서는 데이터 과학자의 80% 이상이 만든 모델이 실제 서비스에 적용되지 못한다는 보고도 있습니다 (즉, 대부분의 모델이 파일럿 단계에서 머물다 폐기됨). 결국 MLOps 부재는 AI 프로젝트의 낮은 성공률로 이어지고, 프로젝트 낭비와 비즈니스 손실을 초래할 수 있습니다.

반면, 성공적인 MLOps의 도입 효과는 모델 개발 사이클이 단축되고 운영 중 장애 감소, AI 활용의 ROI 개선으로 꼽을 수 있습니다. 일관된 파이프라인과 자동화된 테스트·배포 환경을 갖추면, 새로운 모델이나 업데이트를 더 빠르게 출시할 수 있어 시장 대응력 강화로 이어집니다. 또한 MLOps를 통해 모델 및 데이터 변경 시 체계적인 영향도 평가와 모니터링이 가능해져, 모델 품질과 서비스 안정성을 높이고 운영 리스크를 감소시킵니다. 궁극적으로 MLOps를 잘 운영하는 조직은 AI를 실험 수준이 아니라 핵심 비즈니스 동력으로 활용하여 경쟁사 대비 큰 격차를 만들어낼 수 있습니다.

이러한 맥락에서 핵심은, DevOps의 원칙을 ML 전 과정에 자연스럽게 스며들게 해, 개발–배포–운영이 하나의 흐름으로 이어지도록 만드는 것입니다. 이를 위해서는 파이프라인 자동화, 재현성 있는 실험 관리, 표준화된 배포와 운영 모니터링, 그리고 탄력적인 GPU 인프라가 서로 끊김 없이 맞물려야 합니다.

우선, 코드와 모델 변경이 잦은 환경에서는 CI/CD 파이프라인이 필수입니다. 데이터 준비부터 학습, 검증, 배포까지가 하나의 선언적 워크플로우로 묶이면, 배포 전·후의 데이터/모델 검증과 배포 테스트와 같은 과정이 팀 내에 자연스레 녹아들게 됩니다. 운영 파이프라인이 정착하게 되면, 협업 및 배포 주기가 짧아지고 품질 저하 구간을 자연스럽게 줄일 수 있어 AI 운영의 전반적인 비용 감소를 기대할 수 있습니다.

둘째, 협업과 재현성을 위해서는 실험 메타데이터와 아티팩트가 일관된 방식으로 기록·공유되어야 합니다. 어떤 데이터로 학습한 어떤 모델이 어디에 배포되었는지를 한눈에 추적할 수 있으면, 팀 간 소통 비용이 줄고 감사 가능성도 높아집니다. 모델 레지스트리와 파이프라인이 연결돼 있으면 특히 효과적입니다.

셋째, 운영 단계에서는 성능 지표, 지연, 에러율, 데이터·모델 드리프트를 상시로 관찰하고, 임계치 초과 시 알림·롤백·재훈련 트리거가 자동으로 이어지는 피드백 루프가 필요합니다. 모니터링이 파이프라인과 자연스럽게 연결될수록, 성능 저하에 대한 대응 속도는 빨라집니다.

마지막으로, GPU 인프라는 비용과 민첩성의 균형을 좌우합니다. 멀티클라우드·온프레미스를 아우르는 자원 풀에서 작업 특성에 맞춰 자동 배치하고, 스팟과 온디맨드를 상황에 따라 혼합하며, 필요 시 자동 스케일링이 걸리는 구조가 바람직합니다. 표준화된 서빙 계층(컨테이너 기반)과 무중단 배포 전략을 기본값으로 가져가면, 환경 불일치와 수동 배포로부터 파생하는 위험을 낮출 수 있습니다.

이 모든 요소를 개별 도구로 억지로 엮을 수도 있지만, 실제로는 한 곳에서 매끄럽게 이어지는 경험이 성과를 좌우합니다. 예컨대 통합형 MLOps 플랫폼을 선택하면 학습–검증–배포–모니터링이 기본 연결지점으로 제공되고, 멀티클라우드 GPU 최적화나 비용 가시화 같은 운영상의 여백도 함께 메워집니다.

VESSL은 이런 운영 흐름을 자연스레 흡수시킬 수 있는 플랫폼입니다. 저희 플랫폼을 활용하면 인프라와 연결 작업에 사용할 시간을 모델 품질과 비즈니스 성과에 더 들일 수 있습니다.

3. GPU 인프라 운영 자동화 (GPUOps)

딥러닝 및 대규모 AI 모델의 시대에 GPU 인프라는 AI의 핵심 자원입니다. 대용량 연산을 필요로 하는 모델의 학습(training)과 추론(serving)에는 고성능 GPU가 필수적이지만, 이를 기업이 직접 관리하는 일은 결코 만만치 않습니다. AI 열풍과 함께 고성능 GPU 수요가 급증하면서, 안정적인 GPU 인프라 운영은 MLOps 플랫폼 운영의 핵심 과제로 떠올랐습니다. 대규모 GPU 클러스터를 효율적으로 운용하지 못하면 연구개발 속도가 저하되고, 비용은 급증하며, 나아가 서비스에 치명적인 다운타임까지 발생할 수 있습니다. 따라서 GPUOps(GPU Operations의 약자로, GPU 인프라 운영을 자동화하고 최적화하는 것)에 대한 전략이 중요합니다. GPUOps를 구현하면 제한된 GPU 자원을 필요한 곳에 적시에 배분하여 자원 활용률을 극대화하고, 개발자들은 인프라 걱정 없이 모델 개발과 개선에 집중할 수 있습니다.

GPU 인프라를 수동으로 관리하거나 최적화하지 못하면 여러 문제가 발생합니다. GPU 자원을 사용하지 않는 상태인데도 비용이 새는 상황이 벌어지거나, 반대로 필요한 시점에 GPU가 부족해 중요한 모델 학습이나 서비스가 지연될 수 있습니다. 실제로 GPUOps 체계를 도입하기 전에는 엔지니어들이 인프라 장애를 해결하는 데 상당한 시간을 소모해야 했습니다. 이는 본연의 모델 개발 업무를 방해하여 개발 생산성을 저하시키고, 문제 해결에 시간과 인력이 붙잡혀 비용이 증가하게 만들었습니다.

- GPU 드라이버 충돌

- 라이브러리 버전 불일치

- 자원 할당 및 사용에 대한 조직적인 문제

또한 인프라 관리의 복잡성으로 인해 위와 같은 이슈가 빈발하면 서비스 안정성에도 영향을 줍니다. 정리하면, GPUOps를 등한시하면 시간·비용의 낭비와 모델 개발 지연을 초래하고, AI 프로젝트의 민첩성과 신뢰성을 떨어뜨리게 됩니다.

반대로, GPU 인프라 운영을 자동화하고 최적화하면 눈에 띄는 개선 효과를 얻을 수 있습니다. 스캐터랩의 사례에서 알 수 있듯 VESSL은 GPU 인프라 운영 방식의 혁신을 통해 엔지니어들이 더 이상 인프라 문제 해결에 시간을 뺏기지 않고 핵심 플랫폼 기능 개발에 집중할 수 있게 도왔고, 그 결과 플랫폼 완성도와 고객 신뢰도 증가로 이어져 사업 성장에 기여할 수 있었습니다. 또한 GPU 자원을 자동으로 관리하면 클러스터 안정성이 높아져 서비스 중단을 크게 줄일 수 있고, 필요 시 대규모 병렬처리를 통해 모델 학습 속도를 높이며 실험 주기(time-to-experiment)를 단축시킬 수 있습니다. 나아가 자원 활용 효율이 높아지므로 동일한 GPU 예산으로 더 많은 작업을 처리하거나, 동일 작업을 더 저렴하게 수행할 수 있어 비용 절감 효과도 얻게 됩니다.

출처: How VESSL AI accelerates MLOps transformation with Google Cloud | Google Cloud Blog

GPU 자원 관리 자동화를 위해서는 전문적인 클러스터 관리 및 스케줄링 도구를 활용하는 것이 좋습니다. 컨테이너 오케스트레이션 기술(예: Kubernetes)을 도입하면 GPU 워크플로우에 대한 자동 스케일링, 스케줄링, 격리가 가능해집니다. 실제로 VESSL AI는 Kubernetes 기반으로 GPU 클러스터를 구성하여 ML 작업을 동적으로 스케일링함으로써 다양한 GPU 환경에서 모든 ML 워크로드를 통합 실행할 수 있는 플랫폼을 구축했습니다.

또한 자원 요청/반납을 자동화하고 우선순위에 따라 GPU를 할당해주는 스케줄러를 적용하면, GPU 자원이 유휴 상태에 있지 않도록 하고 긴급한 작업에는 신속히 자원을 집중하는 등 정교한 자원 배분이 가능합니다. 예를 들어 VESSL AI의 VESSL Cluster 기능은 클러스터 내에서 GPU 리소스 사용률을 최적화해주는 솔루션으로, 이러한 도구를 활용하면 클러스터 전체의 GPU 활용도를 극대화할 수 있습니다. 마지막으로 모니터링 대시보드를 구축하여 각 팀/프로젝트의 GPU 사용량을 투명하게 파악하고, 리소스 쿼타와 비용 경보를 설정해둠으로써 GPU 사용을 지속적으로 최적화해야 합니다. 이처럼 기술적 툴과 관리 프로세스를 도입한 GPUOps 체계는 AI 인프라 운영의 부담을 줄이고 혁신 속도를 높이는 기반이 되어줄 것입니다.

4. GPUaaS(GPU as a Service) 활용

GPUaaS(GPU as a Service)는 클라우드에서 GPU 인프라를 필요 시에 따라 유연하게 사용하는 모델로, 자체적으로 GPU 서버를 구축·운영하는 대비 비용 효율성과 확장성 면에서 큰 이점을 제공합니다. AI 프로젝트의 특성상 GPU 수요가 일시적으로 폭증하거나 특정 고사양 장비(A100, H100 등)가 필요한 경우가 빈번한데, 사내 인프라만으로 이를 감당하기 어렵습니다. GPUaaS를 활용하면 대규모 GPU 리소스를 온디맨드로 확보할 수 있어, 수요 변화에 탄력적으로 대응할 수 있습니다. 이런 서비스형 모델은 기업이 고가의 GPU 장비를 미리 구매해두지 않고도 최고 성능의 인프라를 활용할 수 있게 해주므로, CAPEX(Capital Expenditures) 부담을 OPEX(Operation Expenditures)로 전환하며 초기 투자 리스크를 줄여주는 효과가 있습니다.

GPUaaS를 도입하지 않고 온프레미스(사내) GPU 인프라에만 의존하는 경우, 수요 예측의 어려움으로 인해 과소하거나 과대하게 투자하는 문제가 생길 수 있습니다. GPU 수요가 급증하면 자체 인프라 용량이 부족해 서비스 지연이나 연구 개발 지체가 발생하고, 반대로 한산할 때는 비싼 GPU가 미사용되며 비용만 낭비될 수 있습니다.

실제로 VESSL AI의 고객사들 중 일부는 다양한 고성능 GPU(A100, H100 등)에 대한 고객사 혹은 사용자의 요구를 자체 인프라로 대응하기 어려워하셨었습니다. 또한 사업이 확장되었을 때를 대비하여 MLOps로의 확장도 필요했기 때문에 VESSL의 GPUaaS를 도입하게 되었습니다. 이와 더불어, 최신 GPU 기술이 빠르게 발전하기 때문에, 온프레미스 장비를 고정 투자하면 시간이 지날수록 구형화되어 성능 및 에너지 효율 측면에서 손해를 볼 수 있습니다. 전력 및 냉각 비용도 자체 인프라 운영 시 기업이 모두 부담해야 하며, 장애 대응이나 유지보수를 위한 추가 인력·노력도 필요합니다.

출처: https://treinetic.com/cloud-service-providers/

결론적으로, GPUaaS를 현명하게 활용하면 AI 인프라 운영의 유연성과 효율을 극대화할 수 있습니다. 구체적으로 말하자면, 필요할 때 필요한 만큼의 GPU를 확보할 수 있으므로 과도한 자원 투자 없이도 대규모 AI 작업을 수행할 수 있고, 사용한 만큼만 지불하므로 비용 최적화에 유리합니다. 전문 클라우드 업체의 GPUaaS는 AWS, Azure, 구글 클라우드 등 주요 프로바이더를 통해 글로벌 리전에 걸쳐 공급되므로, 전세계 어디서나 AI 서비스를 확장할 수도 있습니다. 또한 클라우드 사업자들이 제공하는 최신 GPU 아키텍처와 전용 고속 네트워크, 병렬 스토리지 등을 곧바로 활용함으로써 성능 저하 없이 대규모 AI 워크로드를 처리할 수 있습니다.

또한 비즈니스 측면에서, 기업은 사용자의 수요에 맞게 서비스에 집중할 수 있게 하고 인프라 이슈는 클라우드에 맡겨 운영 효율을 높일 수 있다는 장점이 있습니다. 더불어 GPUaaS는 전문 엔지니어의 기술 지원을 수반하는 경우가 많아, 자체 인력으로 해결하기 어려운 기술 문제도 신속히 도움을 받을 수 있습니다. 정리하면, GPUaaS 활용은 고성능 AI 인프라를 낮은 진입장벽으로 확보하여 비즈니스 요구에 따라 확장·축소하고, 운영 부담을 줄여 핵심 업무에 집중할 수 있게 해줍니다.

이렇듯 AI 인프라의 중심축을 담당하는 GPUaaS를 안정적으로 기업 내부에 도입하기 위해서는 먼저 신뢰할 수 있는 GPUaaS 제공업체를 선정하는 것이 중요합니다. AWS, Google Cloud, Azure 등 글로벌 클라우드의 GPU 서비스는 검증된 안정성과 다양한 인스턴스 옵션을 제공하므로 주요 후보가 됩니다. 아울러 클라우드 비용을 최적화하기 위해 멀티 클라우드 전략도 고려할 수 있습니다.

VESSL과 같은 MLOps 플랫폼을 활용하면 멀티클라우드/하이브리드 설계를 내부 인프라 상황에 맞게 도입할 수 있습니다. 이러한 플랫폼으로 멀티클라우드 전략을 구성하면 여러 클라우드 제공자의 GPU를 활용하고, 각 작업에 가장 비용 효율적인 리소스를 자동으로 선택해 고객 비용을 크게 절감할 수 있습니다.

하이브리드 전략에서는 온프레미스 GPU를 보유한 기업이 부족한 수요 부분만 클라우드로 버스팅(bursting)하는 방식을 채택할 수 있습니다. 온프레미스와 클라우드를 조합한 하이브리드 환경을 구성하면 비용 절감과 동시에 유연성을 확보할 수 있습니다. 예를 들어, 평상시에는 내부 GPU를 사용하다가 피크 시에만 클라우드 GPU를 추가로 활용하는 스케줄링 방식이 효과적입니다. GPUaaS 도입 시 비용 통제와 보안에도 주의해야 합니다. 클라우드 GPU 사용량과 비용을 모니터링하고, 예산 초과 알림을 설정하며, 클라우드 리소스 접근 권한을 엄격히 관리하여 데이터 및 모델 자산의 보안과 규제 준수를 확보해야 합니다. 이런 접근 방식을 통해 기업은 필요한 만큼의 GPU를 경제적으로 사용하면서도 AI 인프라의 확장성을 확보할 수 있습니다.

5. 모델 서빙 및 배포

출처: VESSL 플랫폼

모델 서빙(serving)은 개발된 AI 모델을 실제 운영 환경에 배포하여 예측 서비스를 제공하는 단계로, AI 가치 실현의 마지막 관문입니다. 뛰어난 AI 모델도 적절히 배포되지 않으면 사용자나 시스템이 활용할 수 없어 무용지물입니다. 기업이 AI를 통해 실질적인 비즈니스 가치를 얻으려면, 만든 모델을 제품과 업무 프로세스에 통합해 실시간으로 활용해야 합니다. 예를 들어 추천 모델은 웹사이트에 실시간으로 개인화된 상품을 추천해야 의미가 있고, 수요 예측 모델은 예측 결과가 바로 공급망 결정에 반영될 때 효용이 있습니다. 이러한 실시간 예측 서비스를 뒷받침하려면 모델을 신뢰성 있게 배포하고 24/7 안정적으로 운영해야 합니다. 따라서 모델 서빙 인프라를 어떻게 구축하느냐가 AI 서비스의 실제 도입에 대한 성패를 좌우한다고 해도 과언이 아닙니다.

모델 서빙을 체계적으로 하지 못할 경우 여러 문제가 발생합니다.

- 개발 환경과 운영 환경 사이의 불일치로 인한 오류가 생길 수 있습니다. Google 개발 지침에서도 “훈련 환경의 모델이 운영(서빙) 환경에서도 동일한 성능을 내는지 테스트하라”고 권고할 만큼, 배포 환경 설정이 잘못되면 모델이 엉뚱한 결과를 출력하거나 예측 정확도가 크게 떨어질 수 있습니다. 예컨대 데이터 전처리 로직이나 피처 스케일링 방법이 훈련 시와 서빙 시 다르면 모델 출력에 치명적인 오차가 발생합니다.

- 둘째, 확장성과 응답 속도 문제가 생길 수 있습니다. 서빙 인프라를 잘못 구성하면 사용자가 늘어날 때 요청을 감당하지 못해 응답 지연(latency)이나 시스템 다운타임이 발생합니다. 실제 사례로, 한 금융 서비스의 AI 모델이 배포 초기에 트래픽 급증을 견디지 못해 서비스 장애를 겪었는데, 이는 자동 스케일링 설정 미비와 리소스 모니터링 부족으로 인한 것이었습니다.

- 셋째, 배포 파이프라인의 미흡으로 새 모델이나 업데이트 반영에 오랜 시간이 걸리거나 오류를 동반할 수 있습니다. 수동 배포를 하면 사람에 의한 실수가 발생하기 쉽고, 롤백(Rollback) 절차가 준비되어 있지 않으면 문제가 생겼을 때 신속한 복구가 어렵습니다. 이처럼 모델 서빙을 제대로 하지 않으면 사용자에게 AI 서비스를 원활히 제공하지 못하고, 내부적으로도 모델 업그레이드에 긴 시간이 소요되어 비즈니스 민첩성이 떨어지는 결과를 낳습니다.

모델 서빙 및 배포를 잘 설계하면 AI 모델의 가치가 최대화됩니다. 안정적인 서빙 인프라를 통해 애플리케이션은 실시간으로 지능형 기능을 제공할 수 있고, 이는 곧 개선된 사용자 경험과 업무 효율로 이어집니다. 예를 들어 한 이커머스 기업은 추천 모델을 효율적으로 서빙하여 페이지 로딩 지연 없이 개인화 추천을 제공함으로써 매출이 향상되었습니다. 또 다른 기업은 ML 모델을 마이크로서비스로 배포하고 CI/CD를 적용해 모델 업데이트 주기를 크게 단축했습니다. 그 결과 경쟁사보다 더 빈번하게 AI 기능을 개선하여 제품 혁신 속도를 높일 수 있었다고 합니다. 이처럼 효과적인 모델 서빙 체계를 갖추면 AI 프로젝트의 ROI를 극대화하고, 새로운 모델의 시장 적용 시간을 단축하여 비즈니스 기회를 선점할 수 있습니다. 또한 자동화된 배포 파이프라인을 통해 사소한 모델 개선도 신속히 반영할 수 있으므로, 실험과 피드백 사이클이 빨라져 AI 모델의 지속적 개선(CI/CD/CT)이 가능해집니다.

출처: VESSL 플랫폼

모델 서빙 및 배포에서도 중요하게 고려해야 할 사항들이 있지만 그 중 가장 중요한 요소를 꼽자면, 단연 모델 배포 파이프라인의 표준화와 자동화가 핵심입니다. 먼저 모델을 배포할 환경을 컨테이너화하면 환경 차이에 따른 문제를 줄일 수 있습니다. Docker 등으로 모델 서비스를 패키징하고 Kubernetes, Docker Swarm 등의 오케스트레이션 도구로 배포하면, 어느 환경에서나 일관된 동작을 보장할 수 있습니다. VESSL에서는 사용자가 일일이 패키징하지 않아도 배포가 가능하게 Docker image나 CUDA 버전 등을 미리 셋업하여 MLOps 이용에 사용자의 편리함을 추구합니다. 물론, 하드웨어 자원 선택과 스케일링 전략도 중요합니다. 예를 들어, 초기에는 CPU 기반으로 배포하다가 응답 지연이 발생하면 GPU 인스턴스로 옮기거나, 트래픽 증가 시 인스턴스 수를 자동으로 늘리는 설정을 해두어야 합니다. 무중단 배포(blue-green deployment, Canary 배포 등) 기법을 도입하면 모델을 새로운 버전으로 교체할 때 서비스 중단 없이 점진적으로 전환하여 안정성을 높일 수 있습니다. 또한 모델 성능 모니터링을 배포 프로세스에 통합해, 배포 후 모델의 응답 속도, 에러율, 리소스 사용량 등을 실시간으로 체크하고 문제가 발견되면 자동으로 이전 버전으로 롤백하는 메커니즘을 마련해야 합니다.

마지막으로 CI/CD 파이프라인에서 테스트 자동화를 포함해야 합니다. 테스트 자동화는 실제 사용자인 머신러닝 엔지니어들이 가장 만족도를 느낄 기능 중 하나라고 할 수 있습니다. 자동화가 되면, 모델을 업데이트할 때마다 데이터 및 출력에 대한 재현 테스트(regression test)를 실행해 새 버전이 기존 버전 대비 성능 향상 혹은 유지됨을 확인하고 배포하도록 하는 과정이 편리 및 유연해집니다. 이러한 접근을 통해 모델 서빙은 신뢰성과 유연성을 갖춘 서비스로 거듭나며, 기업은 AI 서비스를 안정적으로 확장 및 운영할 수 있게 됩니다.

6. 확장성(Scalability)

AI 활용의 범위가 커질수록 시스템의 확장성(Scalability)은 필수적인 속성으로 고려해야 합니다. 처음 한두 개의 모델을 운영할 때는 문제가 없던 시스템도, 모델이 열 개, 백 개로 늘어나거나 사용자 트래픽이 기하급수적으로 증가하면 기존 구조로는 감당이 안 될 수 있습니다. AI를 전사적으로 확대 적용하여 회사의 수익에 실질적 기여를 하려면, 조직 전체에 걸쳐 기술을 확장(scale)하고 핵심 비즈니스 프로세스 곳곳에 AI/ML 시스템을 주입해야 합니다. 이를 뒷받침하려면 데이터, 인프라, 인력 측면에서 대규모 요구를 수용할 수 있는 아키텍처와 운영체계가 필요합니다. 예컨대 하루 수억 건의 이벤트를 처리해 예측을 내리는 모델이라면, 처음에는 1개의 서버로 시작했다가도 성공적으로 안착하면 10개, 100개의 서버로 확장할 수 있어야 하며, 그렇지 못하면 비즈니스 기회 손실과 사용자 경험 악화가 발생합니다. 요컨대 AI 프로젝트가 성공적으로 스케일업(Scale-up)하려면, 초기부터 확장성을 고려한 설계와 투자가 필수입니다.

만약 확장성을 간과하면 초기에는 문제없어 보여도 규모의 함정에 빠지게 됩니다. 예를 들어 모델 하나, 소량의 데이터로 시범 운영할 때는 수작업이나 단순 구조로도 돌아가지만, 서비스가 성공해 적용 범위가 늘어나면 시스템이 버티지 못하고 병목이 드러납니다. 수십~수백 개의 모델을 사람이 일일이 관리하려 하면 통제가 불가능하고, 데이터량이 폭증하면 기존 파이프라인으로는 지연과 오류가 속출합니다. 몇 개의 ML 모델만 있어도 지속적 모니터링과 재학습이 필요하고, 수백 개가 되면 그 작업의 경우는 더 쉽지 않습니다.

이는 확장의 어려움을 단적으로 보여줍니다. 실제 사례로 한 글로벌 기업은 다양한 국가와 제품 라인별로 수백 개의 예측 모델을 운영하려 했지만, 인프라와 프로세스 미비로 모델 절반 이상이 업데이트나 품질 관리를 따라가지 못하고 폐기된 일이 있습니다. 또한 확장성 부족은 비용 비효율을 낳기도 합니다. 작은 규모에서는 눈에 띄지 않던 비효율도 규모가 커지면 비용이 기하급수적으로 증가해 수익성을 악화시킵니다. 요약하면, 확장성을 확보하지 못하면 AI 프로젝트는 일정 규모 이상으로 성장하지 못하고 한계에 부딪히며, 오히려 성공이 독이 되어 시스템 장애나 운영 실패를 초래할 위험이 있습니다.

확장성을 염두에 두고 AI 시스템을 구축하면, 사업 성장에 따라 AI 서비스도 무리 없이 규모를 키워나갈 수 있습니다. 충분한 확장성을 갖춘 기업은 데이터 양이 10배로 늘거나 사용자가 폭주해도 안정적인 서비스를 제공할 수 있어 고객 신뢰를 얻습니다. 또한 더 큰 규모의 데이터를 활용할 수 있다는 것은 모델 정확도 향상과 더 정교한 인사이트 도출로 이어집니다.

출처: Measure and Improve AI Workload Performance with NVIDIA DGX Cloud Benchmarking | NVIDIA Technical Blog

예를 들어, NVIDIA의 실험에 따르면 GPU 클러스터 규모를 확장하여 학습을 분산 처리하면 전체 학습 시간을 획기적으로 단축할 수 있으며, 비용도 선형적으로 증가하지 않고 효율적으로 통제할 수 있다고 합니다. 이는 곧, 적절히 확장된 인프라가 신속한 모델 학습과 실험을 가능케 해 개발 사이클을 가속한다는 의미입니다. 더불어 아키텍처 확장을 통해 다양한 신규 AI 활용 시나리오를 추가 비용 부담 없이 수용할 수 있으므로, 기업은 AI 포트폴리오를 넓히고 혁신을 가속할 수 있습니다. 예컨대 모듈화된 마이크로서비스 아키텍처로 모델 서빙을 구성하면, 새로운 모델 서비스를 손쉽게 추가하고 독립적으로 스케일링할 수 있어 다양한 AI 기능을 동시에 확장하는 데 유리합니다. 결과적으로 확장성을 확보한 AI 인프라는 비즈니스 성장과 AI 활용 확대를 견인하는 원동력이 됩니다.

어떻게 하면 좋을까요? 우선 설계 단계부터 확장성을 고려하여 설계하는 것이 중요합니다. 기술적으로는 분산 처리와 병렬화를 최대한 활용할 수 있는 아키텍처를 택해야 합니다. 예를 들어 데이터 저장은 분산 파일 시스템이나 데이터 레이크로 구축하고, 모델 학습은 분산 학습 프레임워크(예: Horovod, Distributed TensorFlow 등)를 통해 여러 GPU/노드에서 병렬 처리하는 식입니다. 자동 확장(Auto Scaling) 기능을 적극 도입하여, 서비스 트래픽이나 작업량이 증가하면 시스템 인스턴스 수를 자동으로 늘리고 감소시에는 줄이도록 합니다. 클라우드 환경에서는 이러한 오토스케일러를 쉽게 활용할 수 있으며, Kubernetes 사용 시 HPA(Horizontal Pod Autoscaler) 등을 설정해둘 수 있습니다.

실제로 VESSL의 경우 구글 클라우드의 GKE(Kubernetes 엔진)를 활용해 필요에 따라 ML 워크로드를 동적으로 스케일 아웃함으로써, 모델 학습부터 배포까지 전체 ML 수명주기를 유연하게 운영했습니다. 이처럼 컨테이너 오케스트레이션과 클라우드의 조합은 글로벌 수준의 확장을 가능하게 합니다. 한편 시스템 아키텍처를 마이크로서비스화하여 모델별로 독립 배포 및 확장을 가능케 하면, 특정 모델에 트래픽이 몰려도 다른 서비스에 영향 없이 해당 모델 서비스만 증설할 수 있어 효율적입니다. 마지막으로 확장에 따른 비용 관리 전략도 함께 마련해야 합니다.

흔히 확장 = 비용 증가를 의미하지만, 클라우드 리소스 예약, 스팟 인스턴스 활용, 멀티클라우드 비용 비교 등을 통해 확장 수준에 맞는 최적 비용 구조를 설계해야 합니다. 이러한 접근을 통해 기업은 AI 서비스 이용자가 10배, 100배로 늘어나도 안정적이고 경제적으로 대응할 수 있는 탄탄한 기반을 갖추게 될 것입니다.

7. 비용 최적화

AI 모델 운영에는 상당한 비용이 수반됩니다. 대규모 데이터를 저장·처리하는 데이터 인프라 비용, 모델 학습과 추론을 위한 GPU 클라우드 비용, 인력 및 기타 운영 비용 등이 누적되면서 자칫하면 프로젝트 비용이 예상치를 크게 초과할 수 있습니다. 특히 GPU 클라우드 요금은 사용 시간과 자원량에 비례하기 때문에, 최적화를 소홀히 하면 “요금 폭탄(bill shock)”을 맞을 우려도 있습니다. 아무리 뛰어난 AI 모델도 경제성이 없으면 지속 운영이 어렵기 때문에, 의사결정자 입장에서는 AI 프로젝트의 ROI(투자대비효과)를 확보하기 위해 비용 통제에 각별히 신경 써야 합니다. 비용 최적화를 통해 동일한 예산으로 더 많은 AI 실험과 서비스를 수행할 수 있고, AI 도입에 따른 재무적 리스크를 줄여 경영진의 신뢰를 얻을 수 있습니다.

출처: VESSL 플랫폼

비용 최적화를 하지 않으면 불필요한 지출이나 비효율적인 자원 활용이 발생합니다. 예를 들어 사용률이 낮은 GPU 인스턴스를 장시간 켜두거나, 과도한 스펙의 클라우드 리소스를 요청하는 상황이 빈번하게 일어납니다. 그 결과 프로젝트 예산이 예상보다 빨리 소진되어 도중에 자금 부족으로 중단되거나, 비용 대비 효과가 낮아 사업화 단계에서 책임자들의 질책을 받을 수 있습니다. 또한 최적화를 안 한 경우 같은 작업을 두 번 실행한다든지 리소스 유휴 시간이 길어지는 등의 비효율이 누적되어, 클라우드 비용이 눈덩이처럼 불어남을 겪게 됩니다. 반면 비용 최적화에 성공한 경쟁사는 동일 작업을 더 저렴하게 수행하여 가격 경쟁력이나 투자 여력 면에서 앞서갈 수 있습니다. 요컨대 비용 관리 실패는 AI 프로젝트의 지속 가능성에 치명적이며, 극단적인 경우 경영진이 AI 투자 자체를 축소 또는 철회하는 결과로 이어질 수도 있습니다.

철저한 비용 최적화를 이뤄내면 한정된 예산으로 최대의 AI 성과를 거둘 수 있습니다. VESSL의 고객사 중의 KAIST, 스캐터랩 사례를 보면, 멀티클라우드 전략과 스팟 인스턴스 활용 등을 통해 GPU 비용을 최대 80%까지 절감한 바 있으며, 이처럼 최적화를 통해 확보된 비용 여력은 더 많은 실험과 모델 개선에 재투자되었습니다. 실제로 VESSL 플랫폼을 도입한 기업들 중 AI 모델 개발 시간을 4배까지 단축하고 수백 시간의 인력 시간을 절감함과 동시에, 클라우드 지출을 80%까지 아낀 사례가 있습니다. 비용을 절감하면 경영진 입장에서 AI 프로젝트의 수익성이 개선되어 지속적인 지원을 받기가 쉬워지고, 프로젝트 팀은 절약된 비용으로 추가 인력 고용이나 더 큰 규모의 실험을 시도할 수 있습니다. 또한 비용 최적화 노하우는 동일한 인프라로 더 많은 모델을 운영할 수 있게 해주므로 AI 확장 전략에도 기여합니다. 궁극적으로 효율적인 비용 관리 하에 운영되는 AI 프로젝트는 재무적으로 건전하고 장기적인 혁신을 견인하는 원동력이 됩니다.

비용 최적화를 위한 첫 번째 규칙으로는, 명확한 원칙과 도구를 갖고 비용을 지속적으로 모니터링 및 최적화해야 합니다.

- 워크로드에 적합한 리소스를 선택해야 합니다. 예를 들어 전처리나 간단한 추론에는 CPU 인스턴스로 충분하며, 무턱대고 GPU를 쓸 필요가 없습니다. 비용을 위해서는 GPU가 꼭 필요한 작업에만 할당하고, 이외 작업은 CPU로 할당해야 합니다.

- 자동화된 자원 할당으로 필요한 때에만 리소스를 쓰도록 합니다. 스케줄러를 활용해 업무 시간 이후에 개발 환경을 자동 종료한다거나, 사용하지 않는 세션을 자동으로 파기하는 등의 정책을 적용합니다.

- 모니터링과 알림을 설정해 비용 지표를 실시간으로 추적합니다. 클라우드 벤더의 비용 관리 도구(AWS Cost Explorer 등)나 서드파티 솔루션을 활용해 서비스별 비용, 팀별 비용을 투명하게 집계하고, 예산 임계치에 근접하면 팀에 알림을 주어 사전에 대응하게 합니다.

- 비용 최적화를 위한 문화를 조직에 정착시켜 구성원들이 비용 최적화를 습관화하도록 유도합니다. 예를 들어 비용 리포트를 정기 공유하고, 모델 한 번 돌릴 때 드는 비용을 가시화해주면 데이터 사이언티스트/머신러닝 엔지니어들이 실험 설계를 효율적으로 하도록 동기를 부여할 수 있습니다. 이러한 접근으로 비용 최적화를 지속하면 동일한 예산으로 더 많은 성과를 내고, 불필요한 지출 없이 AI 프로젝트를 안정적으로 운영할 수 있습니다.

8. 모델 모니터링 및 유지보수

AI 모델은 한 번 배포하고 끝나는 것이 아니라, 지속적인 모니터링과 관리가 필요한 “살아있는 유기체”와도 같습니다. 시간이 지남에 따라 데이터 분포가 바뀌고 외부 환경이 변하면 모델 성능이 저하될 수 있으며, 처음엔 양호했던 모델도 점차 편향 또는 에러가 누적될 수 있습니다. 예를 들어 팬데믹 이전에 학습된 수요 예측 모델은 팬데믹 이후의 소비 패턴 변화에 대응하지 못해 엉뚱한 예측을 내놓을 수 있습니다. 따라서 모델이 운영 환경에서 올바로 동작하는지, 예상 대비 성능은 어떤지를 지속적으로 추적해야 합니다. 모델 모니터링은 단지 성능 유지뿐 아니라, 규제 준수(예: 차별 여부 모니터링), 시스템 안정성 확보, 비즈니스 KPI 연동 등 다방면에서 중요합니다. 한마디로 운영 중 모델을 방치하지 않고 주기적으로 건강 검진을 해주어야 AI 시스템이 처음 의도한 목적을 계속 달성할 수 있습니다.

모델 모니터링을 하지 않으면 문제가 발생해도 알지 못하고 방치하게 됩니다. 예컨대 금융사기의 패턴이 진화하여 모델이 더 이상 새로운 유형의 사기를 잡아내지 못해도, 모니터링이 없다면 이를 알아채기까지 수주 또는 수개월이 걸릴 수 있습니다. 그 사이에 막대한 피해와 오탐률 상승이 발생해 고객 불만이나 손실이 커질 수 있습니다. 또한 모델 출력에 편향이나 오류가 누적되어 특정 집단에 체계적으로 불이익이 가해지는 문제 등이 생겨도, 모니터링 부재 시 이는 사회적/윤리적 이슈로 비화될 때까지 발견되지 않을 수 있습니다.

기업 내에서는 어떤 모델을 도입하냐의 의사 결정보다도 오히려 모델을 어떤 주기로 트레이닝, 모니터링, 배포 및 업데이트를 할 것이냐가 질문이 되어야 합니다. 일정 시간이 지나면 데이터 드리프트(시간 경과에 따른 입력 데이터 분포 변화)가 발생해 모델 예측 정확도가 떨어져도, 주기적인 평가를 하지 않으면 모델 성능 하락 추이를 놓쳐 비즈니스 의사결정 품질이 서서히 저하됩니다. 궁극적으로 모니터링 없이 운영된 모델은 예측이 실제와 괴리되어 신뢰를 상실하게 되고, 어느 순간 성능이 급격히 악화되어 서비스 장애나 사고로 이어질 위험도 있습니다. 결론적으로, 모니터링과 유지보수가 없으면 모델의 무결성과 유효성을 장담할 수 없게 되며, 초기 성과가 시간이 지날수록 퇴색하거나 예기치 않은 사고로 큰 대가를 치를 수 있습니다.

반면, 체계적인 모델 모니터링과 유지보수를 실시하면 AI 모델의 수명과 성능을 극대화할 수 있습니다. 실제로 지속적인 모델 모니터링은 모델 성능 저하를 막고 모델이 의도된 목적에 맞게 제대로 작동하도록 보장하는 핵심 요소로 꼽힙니다. 지속적인 관찰을 통해 모델의 미세한 이상징후도 조기에 발견하여 신속히 대처할 수 있기 때문에, 치명적인 오류나 시스템 장애와 같은 사고를 미연에 방지할 수 있습니다. 또한 이러한 운영으로 서비스 업타임(uptime)이 향상되는 효과도 얻었습니다. 모델 성능 저하가 탐지되면 새로운 모델로 신속히 교체하거나 성능 튜닝을 선제적으로 수행하여, 항상 최상의 모델이 서비스에 적용되도록 유지할 수 있기 때문입니다.

지속적인 모니터링과 피드백은 AI 애플리케이션의 신뢰성 및 효과 유지를 위해 필수적입니다. 아울러 모델 모니터링으로 수집된 성능 지표를 실제 비즈니스 결과(KPI)와 연계해 분석하면 모델이 비즈니스에 주는 영향력을 계량화할 수 있습니다. 이는 경영진 보고나 모델 ROI 산정에 유용하며, 향후 모델 개선 방향을 결정하는 데에도 근거로 작용합니다.

출처: https://moldstud.com/articles/p-understanding-model-retraining-how-to-keep-your-ai-models-up-to-date

마지막으로, 사용자 피드백이나 예외 케이스를 모니터링함으로써 모델 개선 아이디어를 지속적으로 얻을 수 있습니다. 실제 현업의 피드백 루프를 통합하면 모델 성능 향상과 사용자 만족도 제고에 크게 기여하며, 실시간 사용자 데이터로 개선된 모델은 사용자 참여도와 만족도를 높이는 효과를 보였고 리텐션 상승 수치는 30%에 이릅니다. 이처럼 모델 관찰-학습-개선의 피드백 루프가 원활히 작동하면 시간이 지날수록 모델은 더욱 정교해지고, 기업의 AI 활용 역량은 누적 강화되어 경쟁 우위로 이어지게 됩니다.

전방위적인 모델 모니터링 체계 구축이 요구됩니다.

- 성능 모니터링: 우선 성능 모니터링 지표를 정의해야 합니다. 예측 정확도(정확도, 정밀도, 재현율 등), 오류율, 응답 지연 시간, 서비스 가용성 같은 기술 지표뿐 아니라, 모델 예측이 연결된 비즈니스 지표(매출 증가율, 이탈률 감소 등)도 함께 추적이 필요합니다. 이러한 지표들을 대시보드화하여 실시간으로 모니터링하고, 임계치를 벗어날 경우 알람을 발생시키도록 설정합니다.

- 데이터 드리프트 및 모델 드리프트 감지를 자동화합니다. 통계적 방법으로 입력 데이터의 분포 변화를 탐지하거나, 모델의 출력 분포가 시간이 지남에 따라 변하는지 추적합니다. 예를 들어 KS 검정이나 PSI(Population Stability Index) 등을 사용해 현재 입력 데이터 분포와 초기 학습 데이터 분포를 비교하면 드리프트 징후를 포착할 수 있습니다.

- 주기적 재평가 및 재훈련 일정을 수립합니다. 모델 종류에 따라 매주, 매월 또는 분기별로 홀드아웃 데이터셋이나 최신 데이터로 모델을 재평가하고 성능을 리포트합니다. 필요 시 임계 성능 이하로 떨어진 모델은 재훈련 파이프라인을 가동하여 최신 데이터로 업데이트합니다.

- 운영 중 모델의 예외 케이스 로그를 축적합니다. 모델이 실수하거나 자신없어 한(예: 확률값이 애매한) 사례를 수집하여, 데이터 라벨링을 거쳐 다음 학습 사이클에 포함시킴으로써 모델을 지속 개선합니다.

- 마지막으로, 사전 대응 전략을 마련해둡니다. 만약 모니터링 결과 심각한 이상이 감지되면 자동으로 이전 안정 버전의 모델로 롤백하거나, 문제 원인 파악을 위한 사고 대응 프로세스를 즉시 가동합니다.

9. 보안

AI 모델과 데이터 자산을 안전하게 지키는 것은 기업의 신뢰와 법적 준수를 위해 매우 중요합니다. AI 모델 운영에는 민감한 데이터 활용이 수반되는 경우가 많고, 모델 자체도 기업의 핵심 지적자산입니다. 만약 모델이 내린 결정의 근거 데이터가 유출되거나, 모델 서비스 API가 공격받아 오작동한다면 막대한 손실과 평판 훼손으로 이어질 수 있습니다. 실제로 AI를 부주의하게 운용하다 법적·재무적 리스크를 직면한 사례들이 증가하고 있습니다.

대표적으로 2023년 이탈리아에서는 개인정보 문제로 ChatGPT 서비스가 일시 중단되었고, 미국에서는 AI 생성 콘텐츠와 관련해 저작권 침해 소송이 제기되는 등 AI 활용에 대한 규제가 현실화되고 있습니다. EU가 준비 중인 AI 법안은 위반 시 기업에 전 세계 매출의 7%까지 벌금을 부과하는 조항을 포함하고 있어, 보안 및 규제 준수 실패가 가져올 재무적 타격이 매우 클 수 있습니다. 요컨대 보안을 소홀히 하면 데이터 유출, 사이버 공격, 규제 처벌 등으로 인한 법적·재정적·평판상의 피해가 기업을 덮칠 수 있습니다.

AI 모델 운영에서 보안을 등한시하면 여러 가지 구체적인 위험이 현실화됩니다.

- 고객 개인정보나 기밀 비즈니스 데이터가 포함된 훈련 데이터셋이 유출될 수 있습니다. 이는 개인정보보호법 및 GDPR 등의 위반으로 이어져 거액의 과징금과 소송에 휘말릴 수 있고, 고객 신뢰도에도 치명상을 입힙니다.

- 모델 도난 또는 악용의 위험입니다. 훈련에 막대한 비용이 든 모델이 외부로 유출되면 경쟁사에 전략 자산을 빼앗기는 것이며, 반대로 모델이 악의적으로 조작되면 (예: 모델 파라미터를 변조하거나 백도어를 심는 공격) 의사결정 오류나 보안 사고로 연결될 수 있습니다.

- 서빙 인프라에 대한 사이버 공격이 있습니다. AI API 엔드포인트에 대한 DDoS 공격이나 입력 데이터에 대한 적대적 공격(Adversarial Attack) 등이 발생하면 서비스 다운타임 혹은 잘못된 응답을 유발할 수 있습니다.

- AI 모델 특유의 편향(bias)이나 윤리적 문제가 통제되지 않으면 이것이 보안 이슈로 번질 수 있습니다. 예를 들어 편향된 모델 결정으로 특정 집단에 불이익을 준다면 차별 문제로 인한 법적 분쟁이 발생할 수 있습니다. 이 모든 문제가 결국 기업에 대한 신뢰 상실과 평판 하락으로 이어져 장기적인 피해를 가져옵니다. 맥킨지 2025 글로벌 설문에 따르면 응답 기업의 47%가 생성형 AI 사용으로 인한 부정적 결과를 최소 1건 이상 경험했습니다. 또한 데이터 품질 저하로 인한 AI 성과 저하가 연 매출의 평균 6% 손실로 연결된다는 조사도 있습니다. 따라서 AI 보안·거버넌스를 소홀히 하면 단기적으로 사고 대응·규제 리스크, 장기적으로는 평판과 매출에의 악영향이 누적될 수 있습니다.

반면 보안과 규제 준수를 철저히 관리하면 얻는 이점도 큽니다. 책임 있는 AI 운영(Responsible AI)을 구현한 기업들은 위험을 경감하고 신뢰를 구축하여 AI의 잠재력을 최대화하고 있습니다.

출처: Insights on responsible AI from the Global AI Trust Maturity Survey

실제로 맥킨지에 따르면 Responsible AI에 투자한 기업들은 비즈니스 효율 향상 및 비용 절감(42%), 소비자 신뢰 증대(34%), 브랜드 평판 개선(29%), AI 관련 사고 감소(22%) 등의 뚜렷한 성과를 보고했습니다. 이는 체계적인 보안과 윤리에 관한 프레임워크를 갖출 때 AI 도입의 혜택을 온전히 누릴 수 있음을 보여줍니다. 보안을 강화하면 데이터 및 모델 자산에 대한 내부 신뢰가 높아져, 다양한 부서에서 안심하고 AI를 활용하는 조직 문화 조성에도 기여합니다. 또한 규제 준수를 선제적으로 충족하면 향후 생길 법률 변화에도 유연하게 대응할 수 있어 법적 리스크에 대한 회복탄력성을 갖추게 됩니다. 예를 들어 어떤 금융사는 AI 모델의 결정 로직과 데이터를 투명하게 관리하는 거버넌스를 마련하여 규제 기관으로부터 모범 사례로 인정받고, 동시에 고객들에게도 신뢰를 얻어 시장 점유율을 높였습니다. 이렇듯 견고한 보안 및 준법 체계는 AI 프로젝트의 지속 가능성과 사회적 신뢰를 뒷받침하는 든든한 기반이 됩니다.

AI 서비스를 함에 있어 위험 요소들을 줄이기 위해서는, 기존의 IT 보안 수칙에 더해 AI 특유의 위험 요인까지 아우르는 거버넌스가 필요합니다. 우선 데이터 보안 측면에서, AI 모델 학습에 사용되는 모든 데이터에 대해 접근 권한을 최소 권한 원칙으로 관리하고 암호화 저장을 고려해야 합니다.

VESSL AI의 예를 들면, 자사 플랫폼에서 데이터셋과 모델 아티팩트를 클라우드에 저장할 때 구글 클라우드의 세분화된 액세스 제어를 적용하여 인가된 사용자만 중요 자산에 접근하도록 했습니다. 또한 데이터는 학습 전 비식별화하거나 마스킹하여 개인정보를 보호하고, 필요 시 차등 프라이버시(Differential Privacy) 등의 기법을 도입해 개인정보 침해 가능성을 원천 차단합니다. 애플리케이션 보안 측면에서는 모델 API 엔드포인트에 WAF(Web Application Firewall)을 적용하고, 호출 빈도 제한 및 인증/인가 절차를 두어 비정상 트래픽이나 무단 접근을 차단해야 합니다. 모델 보안도 간과해선 안 됩니다. 적대적 공격을 막기 위해 입력 값에 대한 이상탐지 및 필터링을 수행하고, 모델 출력에 대한 모니터링으로 급작스런 분포 변화나 이상치를 감지해야 합니다. 필요하다면 적대적 훈련/학습(Adversarial Training) 등을 통해 이러한 공격에 내성이 있는 모델을 만들 수도 있습니다. 플랫폼 레벨의 보안으로는 노트북 환경이나 모델 개발 환경에 대한 망분리, 접근통제, 콘솔 활동 로깅 등을 실시해 내부 위협이나 실수로 인한 정보 유출을 예방합니다.

마지막으로, 규제 준수를 위해 AI 모델 및 데이터 사용에 대한 명확한 내부 가이드라인과 교육이 필수입니다. 모델 개발 단계부터 프라이버시, 공정성, 설명가능성 요건을 체크하는 AI 윤리 기준을 적용하고, 법무·보안 부서와 협력하여 정기 감사 및 위험 평가 프로세스를 운영해야 합니다. 이러한 다층적인 보안 접근법을 통해 기업은 AI 시스템 전반의 신뢰성과 안전성을 확보하고, 규제 변화에도 흔들리지 않는 AI 운영 체계를 구축할 수 있을 것입니다.

10. AI 거버넌스 및 규제 준수

AI 활용이 확대될수록 조직 차원의 AI 거버넌스와 윤리·규제 준수가 필수 요소로 부상하고 있습니다.

출처: What is AI Governance? | IBM

AI 거버넌스란 AI 시스템과 도구가 안전하고 윤리적으로 사용되도록 관리하는 프로세스와 기준의 프레임워크를 의미하며, 이를 통해 AI 개발부터 활용까지 전 단계에서 공정성, 투명성, 책임성을 확보하고 법적 요구사항을 충족시키려는 것입니다. 각국 정부와 규제 당국도 최근 AI 규제안을 속속 마련하고 있는데, 내부 거버넌스를 선제적으로 구축하지 않으면 향후 이러한 규제에 대응하지 못해 법적 제재나 사업 차질을 빚을 위험이 높습니다. 예를 들어 EU의 AI법(AI Act)에 대한 법제화가 시행되면 기업들은 AI 시스템의 투명성, 안전성, 비차별성 등을 입증해야 하며, 이를 어길 시 최대 전세계 매출의 7%에 달하는 막대한 벌금에 노출될 수 있습니다. 또한 AI 시스템에서 사고가 발생했을 때 누가 책임질 것인가를 사전에 정해두지 않으면, 문제 발생 시 조직 내 혼선이 커지고 대외 신뢰도도 치명상을 입을 수 있습니다. 무엇보다 AI 기술의 사회적 파급력이 커짐에 따라 윤리적 책임에 대한 대중과 직원들의 요구도 높아지고 있습니다.

출처: https://www.ibm.com/thought-leadership/institute-business-value/report/roi-ai-ethics

IBM Institute for Business Value가 조사에서는 업무 책임자 중 80%가 AI의 설명가능성·윤리·편향·신뢰 문제를 제너레이티브 AI 도입의 주요 장애로 지목할 정도로, 이해관계자들은 AI의 책임 있는 활용에 민감합니다. 요컨대 AI 거버넌스와 윤리 준수를 소홀히 하면 법적 위험, 평판 악화, 내부 혼란으로 이어져 궁극적으로 사업 성과에도 타격을 줄 수 있습니다.

잘못 관리된 AI의 리스크 사례는 이미 현실에서 나타나고 있습니다. 예를 들어 앞서 언급했던, 이탈리아 데이터보호청(Garante)은 개인정보 보호 우려로 ChatGPT 서비스를 한때 차단했는데, 이는 대규모 데이터 수집에 대한 법적 근거를 갖추지 못한 결과였습니다. 결정의 투명성 부족도 큰 문제입니다. 실제로 Apple Card의 신용 한도 책정 알고리즘이 성별에 따른 차별을 했다는 의혹이 제기되어 뉴욕 금융당국의 조사를 받았습니다.

위 사례에서 볼 수 있듯 설명가능성이 부족한 블랙박스 모델은 편향 시비가 생겼을 때 대응이 어려워 대규모 조사와 제재로 이어질 수 있습니다. 조직 내부적으로도 명확한 AI 전략과 거버넌스 없이 각 부서가 제각기 AI를 도입하면 중복 투자나 기술 표준 미흡, 데이터 관리 문제가 발생해 비효율을 낳습니다. 하버드비즈니스리뷰(HBR)는 많은 조직에서 AI가 부서별 섬처럼 도입되어 오히려 전체 전략 실행력이 떨어지는 역효과가 나타나고 있다고 지적합니다.

출처: Insights on responsible AI from the Global AI Trust Maturity Survey

맥킨지의 설문에서 응답 기업들 중 51%는 AI 관련 지식 부족, 40%는 규제 불확실성을 주요 장애로 꼽았는데, 이는 거버넌스 결여로 “무엇을 어떻게 해야 할지 몰라서” 우왕좌왕하거나 실행을 망설이는 상황을 보여줍니다.

최악의 경우 윤리 문제가 터지면 고객과 대중의 불신으로 매출 감소나 주가 하락 등 직접적 피해까지 이어집니다. DataRobot의 조사에서 AI 편향 관련 사고를 겪은 조직 중 62%가 매출 손실, 61%가 고객 이탈을 경험했다고 보고되었으며, 기술 임원들은 고객 신뢰 상실(56%)과 브랜드 평판 훼손(50%)을 AI 리스크의 가장 큰 우려 요인으로 꼽았습니다. 결국 거버넌스를 소홀히 하면 법적 제재, 평판 악화, 내부 혼선이라는 삼중고를 겪으며 AI 전략 자체가 좌초될 위험이 있습니다.

반대로, 탄탄한 AI 거버넌스와 책임 체계를 구축하면 위험을 선제적으로 관리하면서도 AI 혁신을 지속할 수 있습니다. 신뢰성 있는 AI를 운영하는 기업은 규제 변화에도 흔들림 없이 사업을 확장할 수 있고, 투명하고 책임 있는 AI 운영을 통해 브랜드 신뢰도를 높여 경쟁우위를 확보하게 됩니다.

그렇다면 AI 거버넌스 구축은 어떤 방식으로 하는게 좋을까요?

구축 결정과 방식은 톱다운(top-down)으로 추진하는 것이 효과적입니다. 먼저 경영진 차원에서 AI 윤리 원칙과 목표를 수립하고, 전사적인 AI 거버넌스 위원회나 전담 조직을 만들어 거버넌스 체계를 이끌게 해야 합니다. 이 거버넌스 기구에는 데이터 윤리, 법무, 보안, 현업 부서 대표 등 다양한 이해관계자가 참여하여 AI 활용 정책과 책임소재를 정의합니다. 실제 많은 기업들이 AI 윤리위원회/위원회 등을 구성해 법무·기술·정책 부서가 함께 AI 프로젝트를 심의하고 윤리 기준을 점검하고 있습니다. 기업 내부 AI 사용 가이드라인을 제정하여 어떤 데이터와 목적으로 AI를 활용할 수 있는지, 반대로 금지된 활용은 무엇인지 명문화해야 합니다. 또한 모델 등록부(Model Registry)를 운영해 개발되거나 배포되는 모든 AI 모델을 중앙에서 관리하고, 각 모델의 의도된 사용처, 데이터 출처, 성능 지표, 편향 테스트 결과, 책임자 등을 담은 모델 카드(Model Card)를 작성해 둡니다. 이를 통해 내부적으로 누가 어떤 AI 모델을 어디에 쓰고 있는지 한눈에 파악할 수 있어 투명성이 높아지고 책임 추적성이 확보됩니다. 위험 관리 프로세스도 표준화하고 통합해야 합니다. 모델별로 위험 등급을 분류하고, 고위험 모델(예: AI 판단이 생명·안전이나 차별 민감 의사결정에 영향을 미치는 경우)은 별도의 엄격한 검증과 상시 모니터링 체계를 둡니다.

출처: https://www.federalreserve.gov/supervisionreg/srletters/sr1107.htm

실제 금융권에서는 미국 연준의 SR 11-7 지침에 따라 모형검증팀이 독립적으로 모델을 검증하도록 하고 있는데, 이와 유사하게 중요 AI 모델에 대해서는 제3자의 모델 검증이나 외부 감사 절차를 도입하는 것이 바람직합니다. 규제 변화 모니터링도 필수입니다. 글로벌하게 AI 관련 법규 제정 동향을 지속 추적하고, 새로운 규제가 예고되면 선제적으로 내부 정책을 업데이트해야 합니다. 현재 브라질, 중국, EU, 싱가포르, 한국, 미국 등 여러 지역에서 각기 다른 접근의 AI 규제가 추진되고 있지만 공통적으로 투명성, 인간 감독, 책임성, 안전성, 비차별, 프라이버시 등을 핵심 원칙으로 강조하고 있습니다. 조직은 이러한 추세에 맞춰 내부 가이드라인을 정비하고 향후 법제화에 대비해야 합니다. 아울러 전 직원 교육을 통해 모든 임직원이 AI 윤리와 보안의 중요성을 인식하도록 하고, 개발자들에게는 Responsible AI 도구 활용 방법을 훈련시켜 실무에서 윤리 원칙을 구현할 수 있게 해야 합니다. 마지막으로 비상 대응 계획을 마련해 두어, AI로 인한 사고 발생 시 어떻게 커뮤니케이션하고 대응할지 시나리오별로 정해놓는 것이 좋습니다. 예를 들어 오류된 AI 결정으로 피해가 발생했을 때 대외 사과 및 구제 절차, 내부 재발 방지 대책 수립 등을 누가 언제 수행할지 명확히 해두는 것입니다.

이러한 거버넌스 체계는 한번 수립하고 끝내는 것이 아니라 지속적으로 개선해야 합니다. 맥킨지의 글로벌 조사에 따르면 현재 기업들의 평균적인 AI 신뢰성 성숙도는 4점 만점에 2.0 수준에 불과한데, 이는 많은 조직에서 데이터 품질 가이드라인이나 사고 대응 계획 등의 준비가 아직 미흡함을 의미합니다. 거버넌스 수준을 정기적으로 점검하고 부족한 부분은 보완하며, 새로운 기술과 업계 표준을 받아들여 진화하는 거버넌스를 유지해야 합니다. 이렇게 함으로써 기업은 AI를 안심하고 적극 활용할 수 있는 환경을 구축하고, 외부 규제와 내부 윤리 기준을 모두 충족하는 모범적 AI 리더로 자리매김할 수 있을 것입니다.

마무리

지금까지 기업이 AI 모델을 운영할 때 꼭 짚고 넘어가야 할 10가지 요소를 살펴보았습니다. 데이터, 인프라, 프로세스, 보안, 거버넌스에 이르는 종합적 접근이 필요하며, 요약하면 우수한 데이터 파이프라인과 MLOps 프로세스 구축, GPU 인프라의 효율화(GPUOps) 및 유연한 GPU 자원 확보(GPUaaS), 모델의 신속하고 안정적인 배포 및 확장, 비용 최적화, 보안 강화, 지속적인 성능 모니터링과 개선, 그리고 철저한 거버넌스와 규제 준수가 중요합니다. 이러한 원칙들을 충실히 이행한다면, 초기 실험(PoC) 단계에 머무르던 AI 프로젝트도 실질적인 비즈니스 가치를 창출하는 운영 단계로 도약할 수 있을 것입니다.

특히 GPU 인프라 관리와 운영 자동화 측면에서 VESSL AI의 접근은 많은 시사점을 줍니다. VESSL AI는 GPUOps 개념을 도입해 복잡한 멀티클라우드 GPU 환경을 자동으로 최적화하고, GPUaaS 모델을 통해 필요할 때 언제든 대규모 GPU 자원을 확보할 수 있는 구조를 갖추고 있습니다. 이를 통해 VESSL AI의 고객사들은 인프라 관리 부담 없이 AI 모델 개발과 운영에 집중할 수 있었고, 실제로 AI 모델 개발 속도를 최대 4배까지 향상시키면서도 클라우드 비용은 80%까지 절감하는 효과를 얻을 수 있었습니다. VESSL 플랫폼은 자동화된 GPU 인프라 관리, 원클릭 모델 학습·배포, 파이프라인 관리 등을 통해 앞서 언급한 10가지 요소에서의 모범 사례를 구현하고 있습니다.

자사의 AI 모델 운영을 더욱 효율화하고 싶다면, VESSL AI의 GPUOps 및 GPUaaS 기반 솔루션을 도입하여 한 차원 높은 운영 효율과 속도를 경험해보시기 바랍니다. 복잡한 인프라 구축이나 관리에 대한 고민 없이 AI 연구개발에만 전념할 수 있는 환경을 제공함으로써, 귀사의 AI 혁신 여정을 가속화해 드리겠습니다. 지금 VESSL AI 플랫폼을 통해 비용 효율적이고 확장성 있는 AI 운영을 직접 체험하여, 귀사의 비즈니스 경쟁력을 한층 강화해보세요!

출처

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/mlops-so-ai-can-scale

- https://cloud.google.com/architecture/mlops-continuous-delivery-and-automation-pipelines-in-machine-learning

- https://medium.com/sciforce/mlops-as-the-key-to-efficient-ai-model-deployment-and-maximum-roi-d9b96cea8412

- https://blog.vessl.ai/ko/posts/scatterlab-faster-models

- https://cloud.google.com/blog/topics/startups/how-vessl-ai-accelerates-mlops-transformation-with-google-cloud

- https://developers.google.com/machine-learning/guides/rules-of-ml

- https://developer.nvidia.com/blog/measure-and-improve-ai-workload-performance-with-nvidia-dgx-cloud-benchmarking/

- https://moldstud.com/articles/p-understanding-model-retraining-how-to-keep-your-ai-models-up-to-date

- https://www.bbc.com/news/technology-65139406

- https://www.theguardian.com/technology/2019/nov/10/apple-card-issuer-investigated-after-claims-of-sexist-credit-checks

- https://www.theguardian.com/technology/2019/nov/10/apple-card-issuer-investigated-after-claims-of-sexist-credit-checks#:~:text=The algorithm used to set,the company for gender discrimination

- https://hbr.org/2025/09/dont-let-ai-reinforce-organizational-silos

- https://hbr.org/2025/09/dont-let-ai-reinforce-organizational-silos#:~:text=operations%2C enhance decision,deliver on its corporate strategy

- https://www.ibm.com/thought-leadership/institute-business-value/report/roi-ai-ethics

- https://www.ibm.com/think/topics/ai-governance

- https://www.ibm.com/think/topics/ai-governance#:~:text=Artificial intelligence ,and respect for human rights

- https://www.ibm.com/think/topics/ai-governance#:~:text=Effective AI governance includes oversight,to align with society's values

- https://www.ibm.com/think/topics/ai-governance#:~:text=AI ethics boards%3A Many companies,legal%2C technical and policy backgrounds

- https://www.informationweek.com/data-management/the-cost-of-ai-bias-lower-revenue-lost-customers

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/tech-forward/insights-on-responsible-ai-from-the-global-ai-trust-maturity-survey

- https://www.mckinsey.com/capabilities/risk-and-resilience/our-insights/as-gen-ai-advances-regulators-and-risk-functions-rush-to-keep-pace

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/mlops-so-ai-can-scale#:~:text=operations ,native%3A The CEO’s role%2C” McKinsey

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/mlops-so-ai-can-scale#:~:text=When companies embrace MLOps best,on implementing four key practices

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/tech-forward/insights-on-responsible-ai-from-the-global-ai-trust-maturity-survey#:~:text=Insights on responsible AI from,Global AI Trust Maturity Survey

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/tech-forward/insights-on-responsible-ai-from-the-global-ai-trust-maturity-survey#:~:text=Despite the progress%2C obstacles to,indicate that organizations still lack

- https://www.mckinsey.com/capabilities/risk-and-resilience/our-insights/as-gen-ai-advances-regulators-and-risk-functions-rush-to-keep-pace#:~:text=While the approaches vary%2C common,regulatory landscape have emerged globally

- https://www.mckinsey.com/capabilities/risk-and-resilience/our-insights/as-gen-ai-advances-regulators-and-risk-functions-rush-to-keep-pace#:~:text=The current international regulatory landscape,for AI

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/tech-forward/insights-on-responsible-ai-from-the-global-ai-trust-maturity-survey#:~:text=The average RAI maturity score,guidelines%2C and incident response plans

- https://www.mckinsey.com/capabilities/risk-and-resilience/our-insights/as-gen-ai-advances-regulators-and-risk-functions-rush-to-keep-pace#:~:text=Governance,gen AI management and the

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/tech-forward/insights-on-responsible-ai-from-the-global-ai-trust-maturity-survey#:~:text=However%2C a lack of clarity,of AI in their businesses

- https://www.mckinsey.com/capabilities/risk-and-resilience/our-insights/as-gen-ai-advances-regulators-and-risk-functions-rush-to-keep-pace#:~:text=Transparency,is intended to be used

- https://www.mckinsey.com/capabilities/risk-and-resilience/our-insights/as-gen-ai-advances-regulators-and-risk-functions-rush-to-keep-pace#:~:text=Governance,business priorities%2C and regulatory requirements

- https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/tech-forward/insights-on-responsible-ai-from-the-global-ai-trust-maturity-survey#:~:text=Data and technology%3A Tooling for,AI governance and AI safety

- https://cloud.google.com/architecture/mlops-continuous-delivery-and-automation-pipelines-in-machine-learning#:~:text=Data scientists can implement and,Learning%3A The High Interest Credit

- https://cloud.google.com/blog/topics/startups/how-vessl-ai-accelerates-mlops-transformation-with-google-cloud#:~:text=For example%2C many generative AI,ensures our platform can achieve

- https://cloud.google.com/architecture/mlops-continuous-delivery-and-automation-pipelines-in-machine-learning#:~:text=done before deployment by data,train and validate new models

- https://cloud.google.com/blog/topics/startups/how-vessl-ai-accelerates-mlops-transformation-with-google-cloud#:~:text=Many organizations are already experiencing,savings on cloud expenditure

- https://developer.nvidia.com/blog/measure-and-improve-ai-workload-performance-with-nvidia-dgx-cloud-benchmarking/#:~:text=,While adding more

Wayne Kim

Product Marketer

Try VESSL today

Build, train, and deploy models faster at scale with fully managed infrastructure, tools, and workflows.